Новітній час

ЗМІСТ

- Сучасна історія

- Чому перші тостери підсмажували хліб тільки з одного боку

- «Кухонний помічник» за ціною автомобіля

- Перші телевізори з діагоналлю екрану 5 дюймів

- Як зробити бензопилу легшою

- Що могли назвати «аерозольною бомбою»

- «Проти життя»

- Як Шик придумав навести шик

- Покращений кухонний ніж, що став символом Швейцарії

- Сонце випромінює радіоперешкоди?

- Як побачити предмети, розміри яких менші за довжину хвилі світла

- З чого можна зробити тканину, ковдру та… вибухівку?

- Як з’явилися трамполіни для тренування пілотів, штурманів і космонавтів

- За принципом кажана, або Що могли назвати телемобілоскопом

- Композитні матеріали в Композитний вік

- Від копіювального паперу до електронних копіювальних апаратів

- Програмований комп'ютер для військових цілей

- 33 роки банки відмовлялися встановлювати банкомати!

- Що вигадали «Придурки з Тегеля»

- Ядерна енергія на службі війни і миру

- «Дивовижний генератор»

- Дослідження напівпровідників та відкриття транзисторного ефекту

- «Тільки найкраще досить добре»

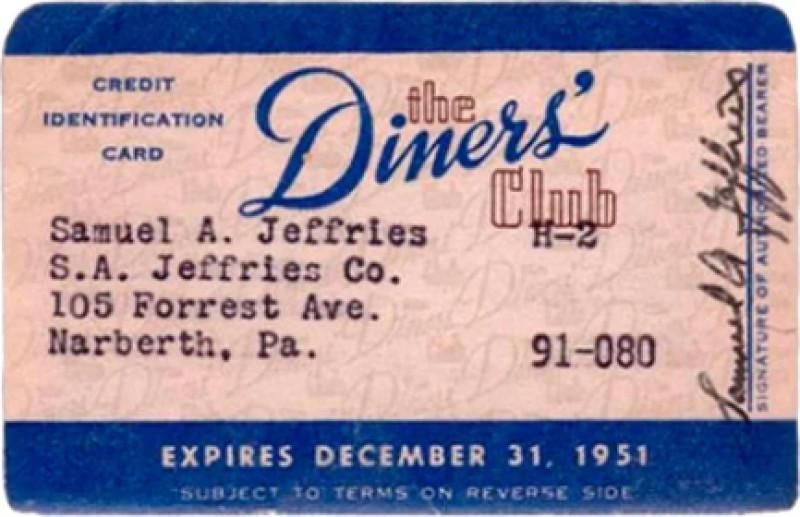

- Шлях від металевих жетонів до інтернет-банкінгу

- Розробка термоядерної бомби

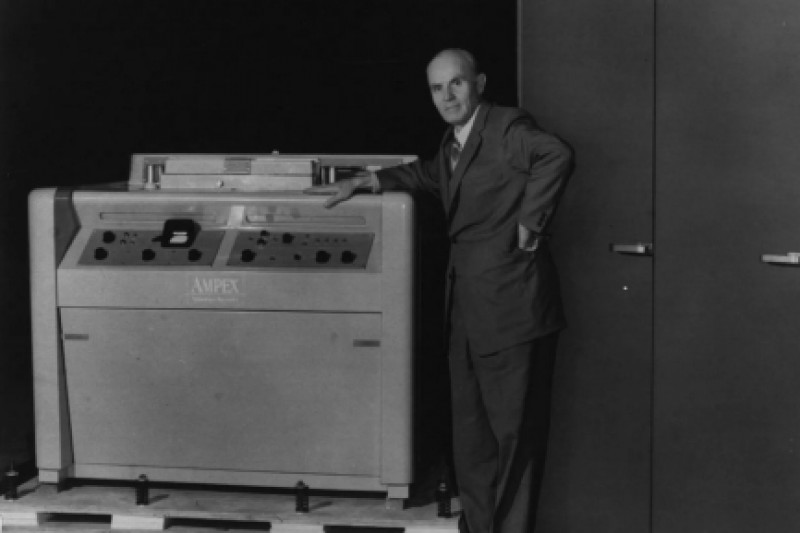

- Революція в індустрії мовлення

- Десятидоларова облігація за створення алмазу

- Сонячні батареї для космічних апаратів та земних електростанцій

- «Атом для миру»

- Штучний інтелект, проблеми та ризики

- Незамінні криголами

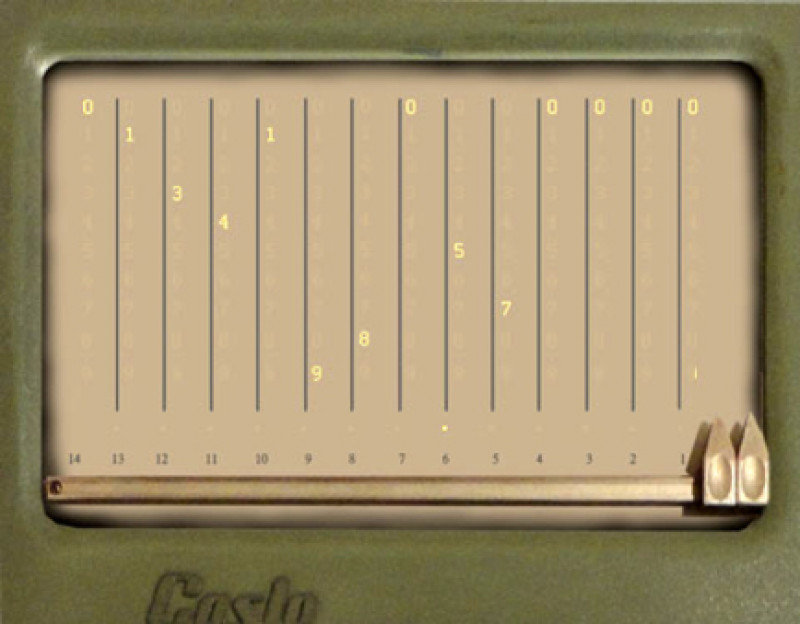

- Нова лічильна машина братів Кашіо

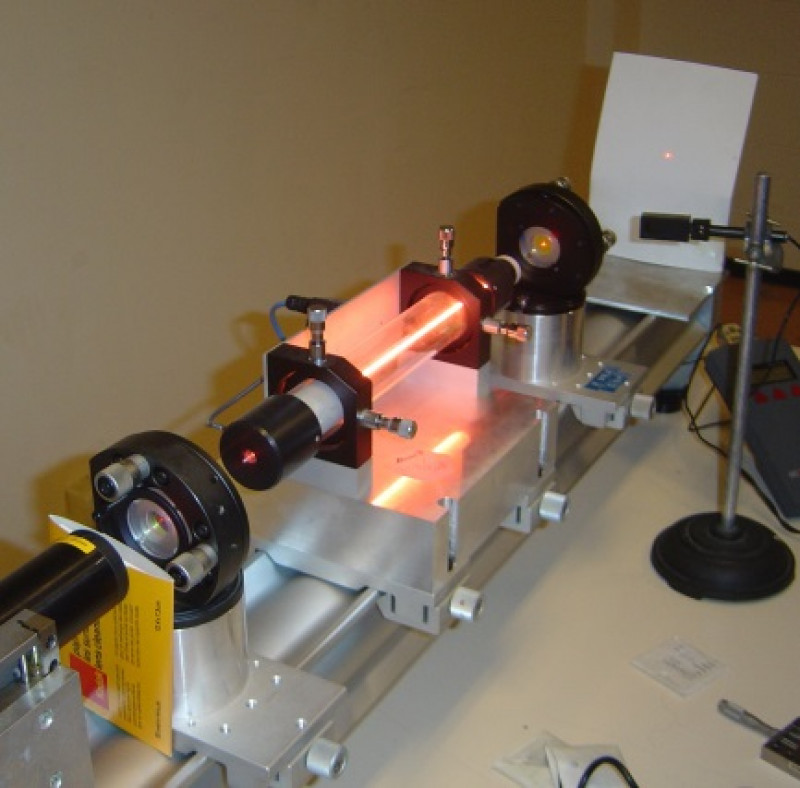

- Лазер, або Оптичний квантовий генератор

- Народження персональних комп'ютерів

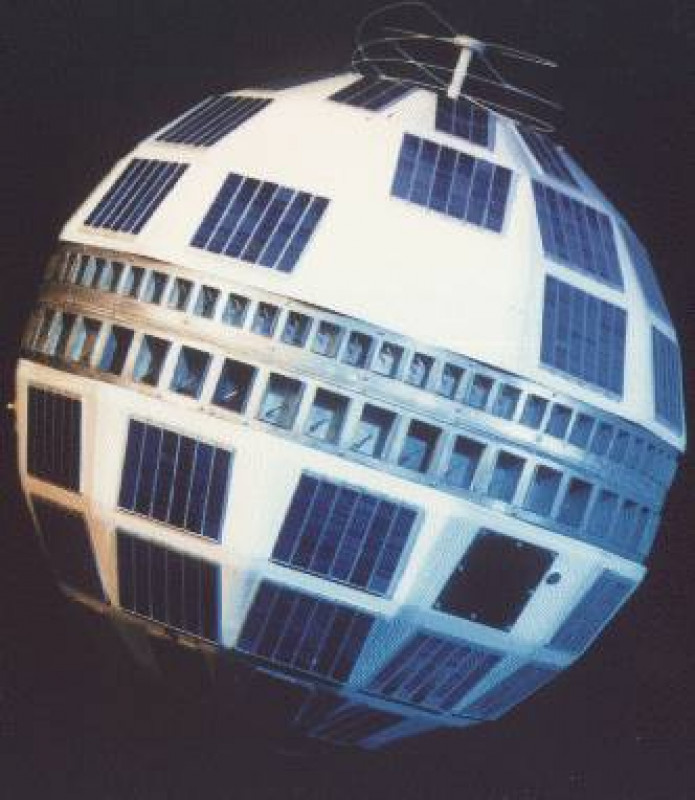

- Розвиток супутникових технологій

- Космічна ера розвитку людства

- Світлодіодні лампи

- Супутники зв’язку та народження супутникового телебачення

- «Швидкісні перегони» на залізниці

- Кварцовий годинник як еталон часу

- «Паличка Джойса», або важіль управління елеронами та кермами висоти

- Дискети й дисководи

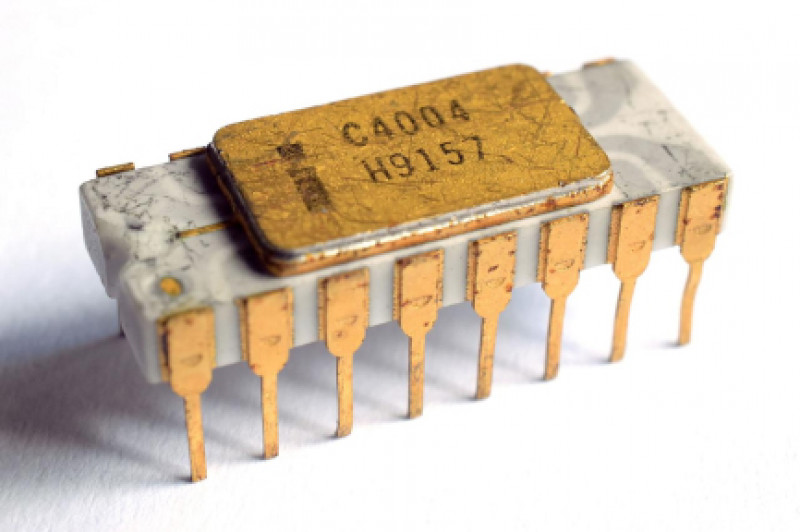

- Мікропроцесори

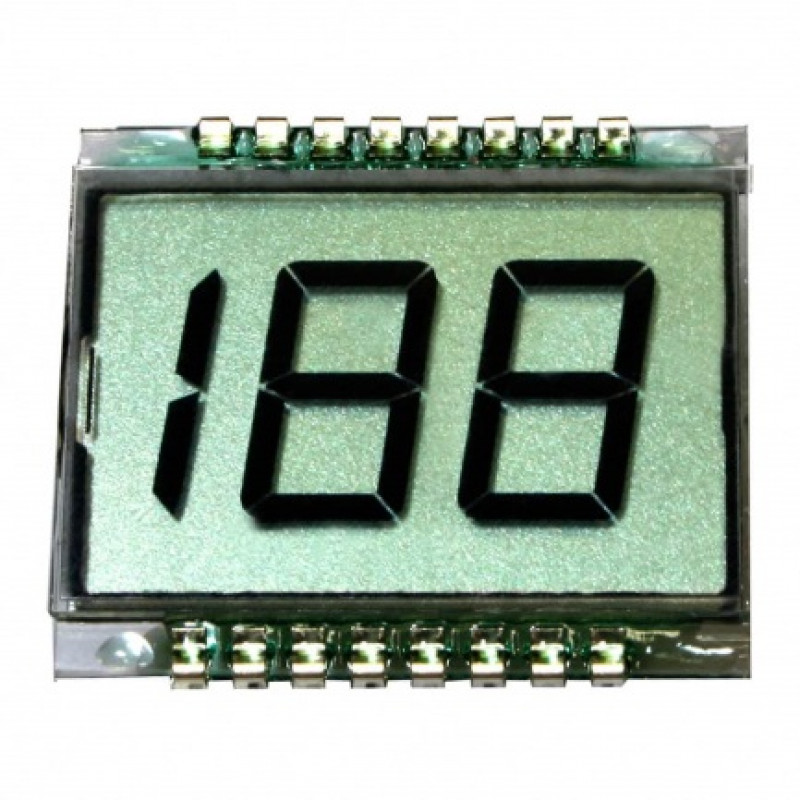

- Дві точки плавлення похідних холестерину та рідкокристалічні технології

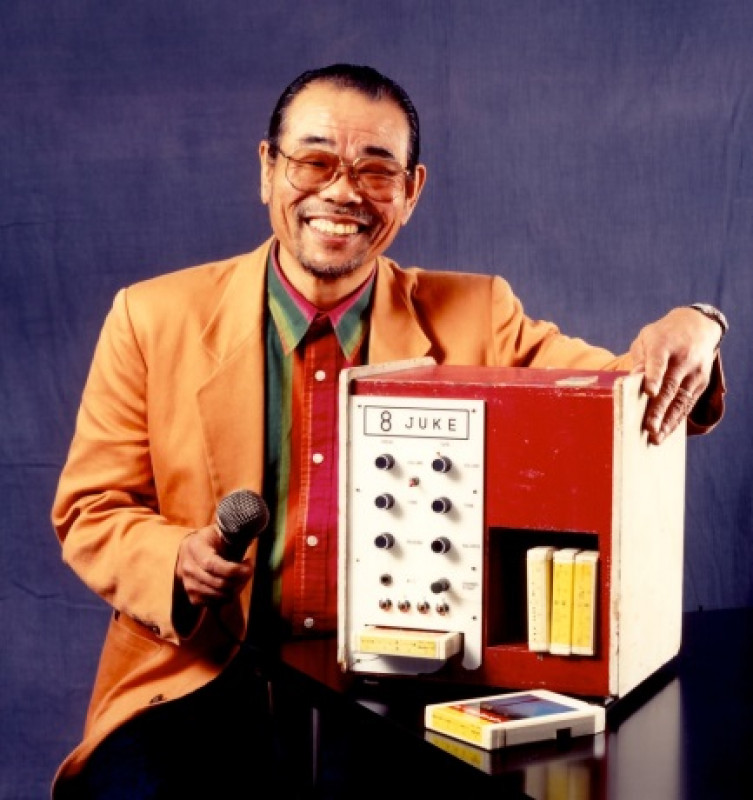

- Переможна хода караоке

- Як сенсорний екран потрапив до масового користувача

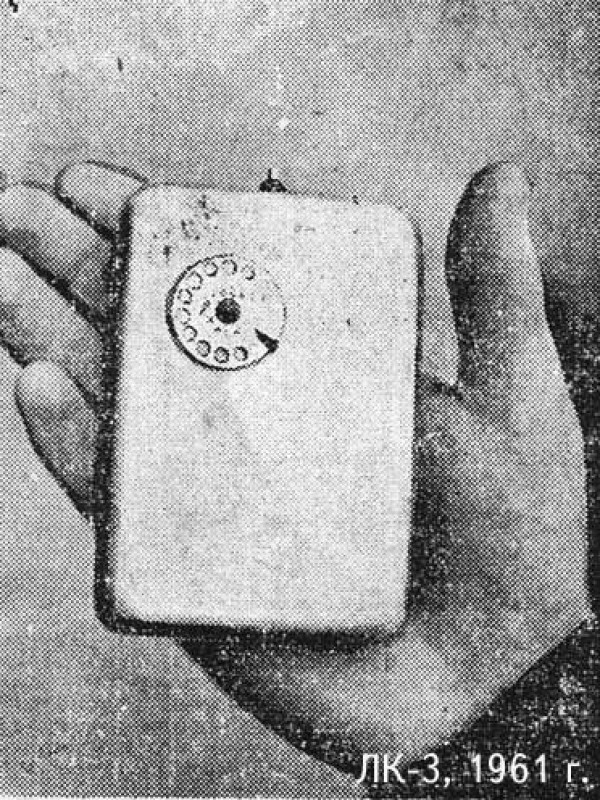

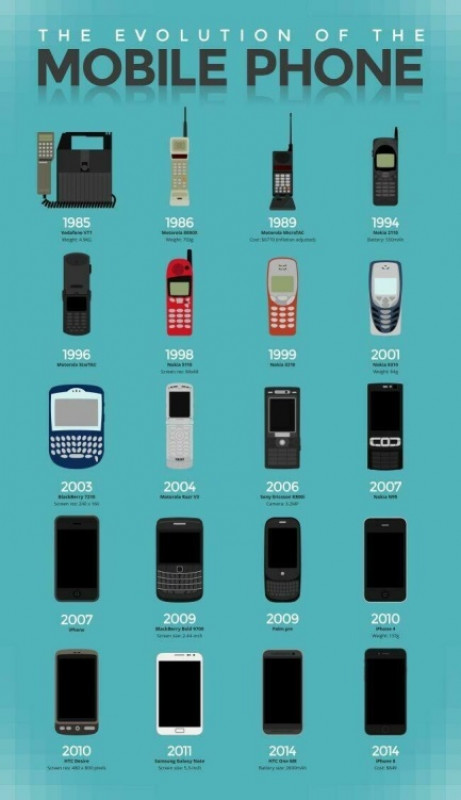

- Як зробити телефон портативним бездротовим пристроєм

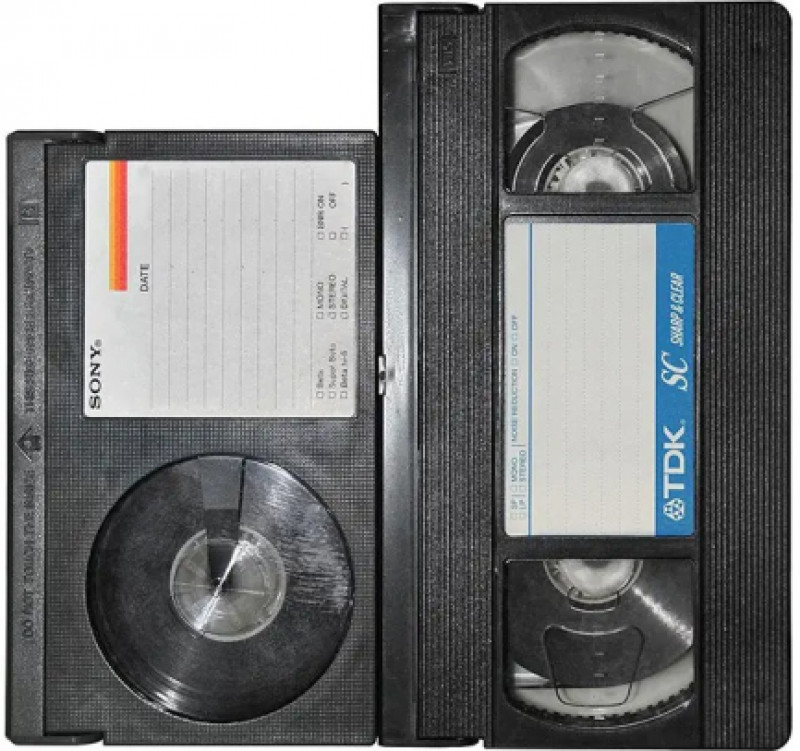

- Пристрої для зберігання даних

- Літій-іонні акумулятори

- Військові розробки комп'ютерної мережі та народження інтернету

- Клонування організмів

- Цифрова революція

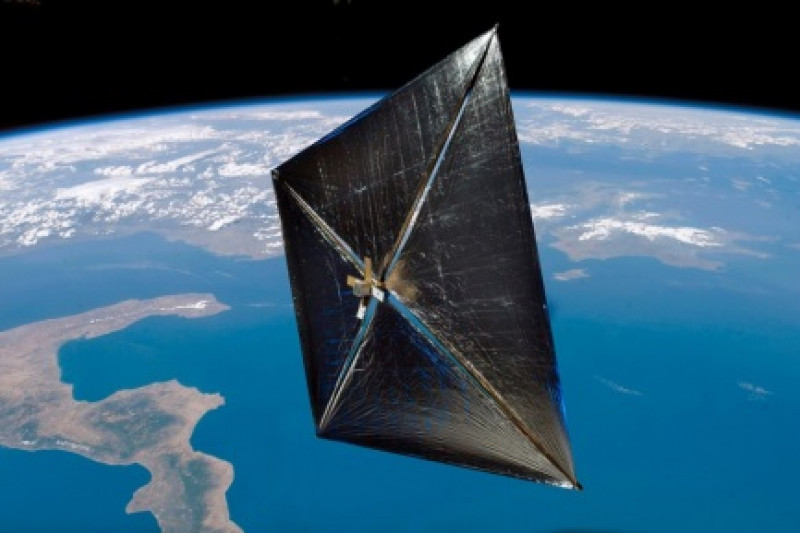

- Як використовувати світловий тиск

- Кіберфізична революція та Епоха уяви

- Бозон Гіґґса, або Частка Бога

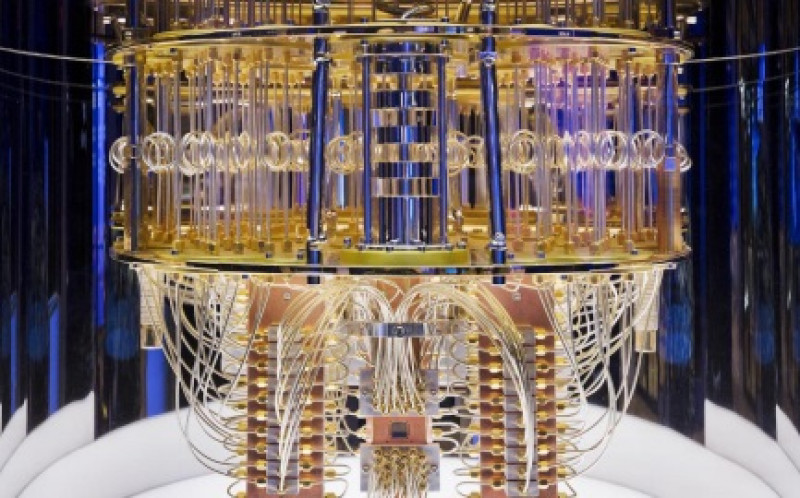

- Квантові комп'ютери

- Життя на Марс

Сучасна історія

Період, який розпочався в 1918 році після закінчення Першої світової війни і триває до цього часу, прийнято називати новітнім часом (в англомовному середовищі більш поширений термін «сучасна історія»).

Переживши перший в історії глобальний військовий конфлікт, у якому брали участь одразу 38 країн, світ почав освоювати нові технології, що супроводжувалося стрімким економічним зростанням і значним підвищенням рівня добробуту людей. Проте вже у 1930-ті роки на зміну бурхливому зростанню економіки США прийшла криза — Велика депресія. Це спричинило зниження обсягів світової торгівлі та загальну фінансову кризу. Скорочення виробництва та зростання безробіття у США призвело до хвилювань у суспільстві, які поширилися і на країни Європи, викликаючи соціальну напруженість та заворушення. В умовах економічної кризи в деяких європейських країнах посилився націоналізм та пошук авторитарних рішень. У таких державах, як Німеччина та Італія, підтримка крайніх правих рухів зросла, що згодом спричинило встановлення фашистських режимів.

Економічна криза посилила конкуренцію за обмежені ресурси, що стало причиною загострення міжнародних відносин. Тарифні бар’єри, введені багатьма країнами у відповідь на економічний спад, ще дужче погіршили ситуацію. У результаті навіть Ліга Націй — організація, створена після Першої світової війни, яка мала би запобігти будь-яким майбутнім конфліктам між країнами, — виявилася безсилою перед новим протистоянням: Другою світовою війною.

Війна, яка забрала життя десятків мільйонів людей, водночас мала величезний вплив на розвиток нових методик, стимулювавши наукові й технічні інновації. Протягом конфлікту вперше було застосовано та розроблено чимало технологій, які згодом стали ключовими у різних галузях. Ядерна енергетика, ракетобудування та подальше освоєння космосу, створення комп’ютерів та нові розробки у сфері електроніки — усе це з’явилося внаслідок військових досліджень.

У повоєнний період країни світу стикалися із необхідністю відновлення зруйнованої інфраструктури, економіки та соціальних структур. Усе це супроводжувалося зростанням виробництва, підвищенням рівня життя та формуванням суспільства споживання. Ключовим фактором у прагненні до покращення умов життя та забезпечення безпеки став інтенсивний науково-технічний прогрес.

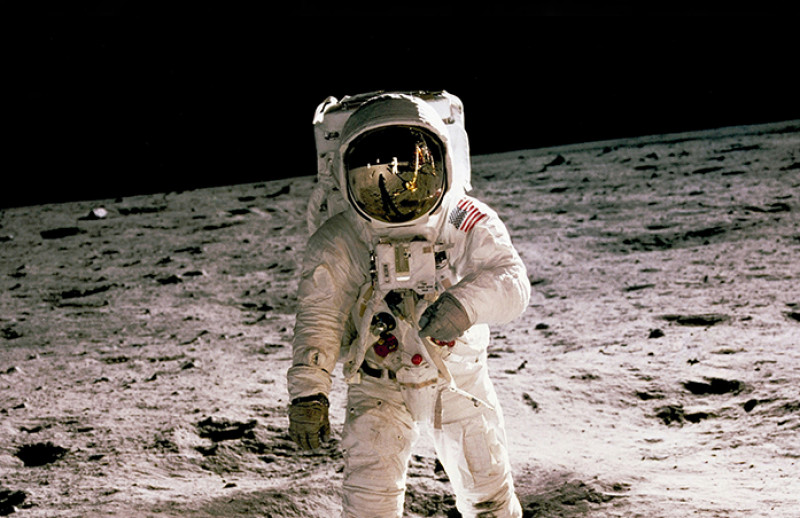

Запуск першого штучного супутника Землі в 1957 році започаткував космічну еру людства. Уже в 1960-ті відбулися перший політ людини у космос і навіть перша в історії висадка землян на поверхню іншого небесного тіла — Місяця. Космічні програми стимулювали розвиток нових технологій, які згодом знайшли застосування у повсякденному житті.

Цифрова революція, пов’язана з переходом від традиційної промисловості, яка виникла в результаті промислової революції та індустріалізації, до економіки, заснованої на обробці даних, започаткувала інформаційну еру. Люди отримали можливість вільно передавати інформацію та мати миттєвий доступ до знань, які раніше було б важко чи зовсім неможливо знайти.

Важливим фактором, що характеризує сучасну епоху, стало значне прискорення темпів наукових і технологічних досліджень, а також доступ до інформації, що постійно розширюється. Своєю чергою більш досконалі методи комунікації та обміну інформацією сприяли якнайшвидшому поширенню та засвоєнню нових ідей. Інакше кажучи, науково-технічний прогрес прискорився до небувалих темпів — можна зазначити, що за рік тепер відбувалося більше відкриттів, ніж у ранні періоди історії за цілі тисячоліття!

Сучасність перебуває на стику між минулим та майбутнім. Учені намагаються спрогнозувати подальший історичний розвиток, ґрунтуючись на накопиченому досвіді людства. Американський філософ іспанського походження Джордж Сантаяна якось сказав: «Хто не пам’ятає свого минулого, приречений пережити його знову». Необхідно враховувати уроки минулого, знаходити закономірності в циклах підйому та падіння цивілізацій у різні історичні періоди, щоб не допустити можливості втрати всіх наукових знань та технологій через будь-які катаклізми, які здатні відкинути людство у розвитку на тисячі років назад або навіть повністю знищити його.

Перший автоматичний тостер

Чому перші тостери підсмажували хліб тільки з одного боку

Ще в давнину було помічено, що підсмажування шматочків хліба робить його більш хрустким, ароматним і надає йому особливого смаку. До того ж на тверду поверхню легше намазувати начинку, а тепло допомагає маслу швидше розплавитися. Тости (так називали підсмажені шматочки хліба, від латинського tostus — жаровня, деко) стали популярними у різних культурах. Вони споживалися на сніданок або у вигляді перекусу.

Для приготування тостів спочатку використовували металеву решітку, покладену над вогнем, або спеціальну виделку з довгою ручкою. Починаючи з XVII століття у Європі й Америці для підсмажування тостів на вогні почали виготовляти спеціальні ковані грилі — тостери.

З появою наприкінці ХІХ століття електричних нагрівальних елементів виникла ідея створення електричного тостера. Однак досить довгий час технічно складним залишалося виробництво надійного елемента, який міг би витримувати багаторазове нагрівання до високих температур, при цьому не втрачаючи міцності і не стаючи занадто крихким. Цю проблему вдалося вирішити в 1905 році, коли інженер Альберт Марш отримав сплав нікелю та хрому, який назвав ніхромом. І одними з перших приладів, де застосували ніхромові нагрівальні елементи, стали саме електричні тостери. Утім, спочатку такі пристрої теж мали свої недоліки: вони підсмажували хліб тільки з одного боку, до того ж необхідно було постійно стежити за тим, щоб тост не пригорів.

Перший автоматичний електротостер із двостороннім нагріванням та вбудованим таймером для своєчасного відключення нагрівального елемента був створений 1919 року Чарльзом Страйтом, який працював звичайним механіком на заводі. А 1925 року компанія Waters Genter внесла ще одне вдосконалення — «вистрибування» тостів із пристрою після їхньої готовності.

Відтоді в конструкції тостерів мало що змінилося, крім хіба що їхнього зовнішнього вигляду, що змінювався, враховуючи модні тенденції. У 1980-х роках деякі висококласні тостери мали функцію автоматичного опускання та підйому тостів без необхідності використовувати важелі — хліб просто закладали в такий «тостер-ліфт». У сучасних тостерах часто застосовуються біметалічні датчики, які відключають нагрівальний елемент, спрацьовуючи від тепла, що йде від тоста, і незалежно від типу хліба або його початкової температури (навіть замороженого шматочка), хліб завжди підсмажується до певної температури.

У рамках концепції Інтернету речей у майбутньому тостери, як і інші побутові прилади, підключатимуться до мережі Інтернет, завдяки чому керувати приготуванням тостів та отримувати повідомлення про стан їхньої готовності можна буде за допомогою смартфона.

Механічний міксер

Один із перших побутових електроміксерів

«Кухонний помічник» за ціною автомобіля

У всі часи кухарям доводилося перемішувати та збивати різні інгредієнти для приготування страв. Коли ж страв готували чималенько, ручне перемішування та збивання потребувало неабияких зусиль і забирало багато часу.

У XIX столітті через зростання міського населення та зміну способу життя людей виникла потреба у швидших та зручніших способах приготування їжі. Цьому сприяла промислова революція, яка зробила доступними більшу кількість металевих матеріалів та інженерних рішень. Усе частіше ручну працю замінювала більш ефективна машинна з використанням механічних пристроїв, зокрема кухонних приладів нового типу.

У 1856 році бляхар Ральф Кольєр із американського Балтімору запатентував перший механічний пристрій для перемішування — міксер з обертовими частинами. Варто зауважити, що міксери з ручним приводом завдяки своїй простоті та зручності досі є у продажу. Поява цього кухонного аксесуара свого часу значно полегшила життя домогосподарок.

Однак для професійних кухарів, яким доводилося готувати страви у великих кількостях, міксери з ручним приводом хоч і допомогли прискорити роботу, але, як і раніше, забирали чимало сил. Поява електричних двигунів та джерел живлення наприкінці XIX — на початку XX століття дала змогу розробити електричні кухонні пристрої, завдяки яким процес приготування страв перестав бути схожим на відвідування тренажерного залу.

У 1908 році інженер Герберт Джонстон, спостерігаючи за тим, як пекар замішував тісто металевою ложкою, задумався над тим, що з подібним завданням міг би чудово впоратися механічний пристрій з електричним приводом. Уже до 1915-го його міксер із 80-літровою чашею був стандартним обладнанням для більшості великих пекарень. А 1919 року в продажу з’явився перший електричний міксер для домашнього використання Kitchen Aid. І хоча цей апарат вагою понад 30 кг займав майже половину кухні, неабияк гримів під час роботи і коштував як новенький автомобіль «Форд», охочі придбати його, щоб перекласти частину домашніх обов’язків на побутову техніку, все одно були.

У 1930-х дизайнер Еґмонт Аренс створив революційну модель міксера, елегантний дизайн якої визначив зовнішній вигляд і функціонал цієї кухонної техніки на багато десятиліть уперед. Одним зі знакових досягнень були знімні вінчики для збивання (раніше вони були намертво з’єднані з корпусом). Завдяки такій особливості міксер займав менше місця, а також спрощувалась процедура його очищення.

Продажі міксерів щодень набирали обертів, але тут настала Велика американська депресія, і всім стало не до міксерів... На довгі роки про будь-які технічні нововведення на кухні довелося забути. Тріумфальне повернення міксерів до домогосподарок відбулося лише в 1950-ті роки, коли післявоєнна промисловість остаточно перейшла на випуск продукції мирного призначення. Нові міксери стали компактнішими, легшими у використанні й часто мали кілька насадок для різних завдань. Тепер цей прилад можна було тримати однією рукою, а довгий шнур давав змогу вільно пересуватися кухнею.

У другій половині XX століття в міксерах почали з’являтися нові функції, такі як плавний пуск та різні режими швидкості. А завдяки розвитку цифрових технологій та електроніки на початку XXI століття міксери отримали більш точний контроль швидкості, програми та різні функціональні можливості. Наприклад, деякі моделі мають вбудовані ваги чи програми для різних рецептів.

Еволюція кухонних міксерів триває, завдяки цьому з’являються нові технології, матеріали й функції, щоб відповідати потребам сучасних користувачів та кулінарних трендів.

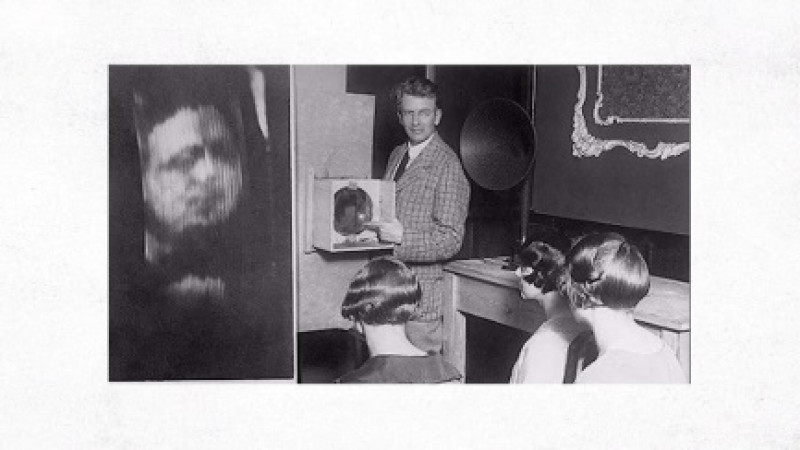

Джон Берд демонструє перший телевізор

Один із перших телевізорів

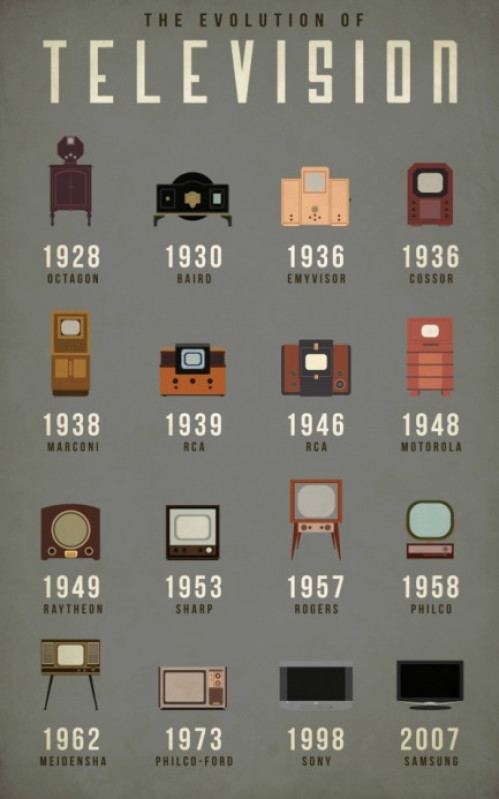

Еволюція телевізорів

Сучасний телевізор

Перші телевізори з діагоналлю екрану 5 дюймів

У 1884 році німецький інженер Пауль Ніпков винайшов пристрій, що став відомим як диск Ніпкова. Це була кругла пластина з отворами, розташованими в певному порядку. Світло проходило крізь ці отвори і фіксувало зображення, немов у фотоапараті, на приймачі, який своєю чергою передавав його на екран. Така механічна обробка рухомого зображення потребувала значного часу і ресурсів, тому була далекою від досконалості.

Шотландський підприємець Джон Лоуґі Берд придумав, як оптимізувати систему передачі зображень на екран так, щоб деталі стали більш чіткими, а рухи — плавними. У січні 1926 року він уперше представив свою систему передачі зображень членам Королівської асоціації та репортерам газети The Times. Це був перший у світі показ справжньої телевізійної (від грецького «теле» — далеко і латинського visio — бачу) системи, що демонструє рухомі зображення в чорно-білому кольорі.

У 1927 році Берд передав телевізійний сигнал по телефонній лінії завдовжки 705 км між Лондоном та Глазго, а ще через рік компанія Берда Baird Television Development Company / Cinema Television здійснила першу передачу трансатлантичного телевізійного сигналу між Лондоном та Нью-Йорком, а також першу передачу з берега на корабель.

До середини 1930-х років компанія Берда практично монополізувала телевізійний ринок. Виготовлені нею пристрої мали форму шафи або трюмо, усередині яких містилися диски Ніпкова та світловий проєктор, а на передній частині було встановлено екран завбільшки з блюдце.

Проте водночас із механічним телебаченням Берда йшла робота над розробкою електронного телевізора. Винахідники прагнули підвищити швидкість обробки сигналу і поліпшити якість зображення, використовуючи електрику і люмінофори, що з’явилися наприкінці XIX століття, — особливі речовини, які випромінюють світло при впливі на них електричного струму. Ще 1897 року німецький фізик Карл Браун створив першу електронно-променеву трубку — кінескоп.

У 1907 році вчений Борис Розінґ значно удосконалив цей винахід, помістивши трубку Брауна в закритий корпус і досягши зображення найпростіших фігур. А в 1908 році англієць Алан Арчібальд Кемпбелл-Свінтон запропонував розгортати зображення в кінескопі за допомогою електронного променя, який буквально малює зображення на люмінофорній поверхні екрана, рухаючись набагато швидше, ніж це може сприймати людське око. У 1911 році винахідник опублікував докладну статтю з описом принципу електронного телебачення, проте до практичної реалізації подібної системи було ще далеко.

Лише 1936 року учень Розінґа Володимир Зворикін, емігрувавши до США, представив перший експериментальний екземпляр електронного телевізора. Масове виробництво таких пристроїв почалося 1939 року. Чорно-білі телевізори Зворикіна були громіздкими, при цьому діагональ екрана ледь сягала 5 дюймів — менше, ніж у багатьох сучасних смартфонах!

Розвитку телебачення у 1940-ті роки завадила Друга світова війна. До речі, інший винахід Зворикіна — електронна трубка, чутлива до інфрачервоного світла — згодом ліг в основу перших пристроїв нічного бачення, які використовувалися під час Другої світової війни для спостережень у темряві.

Епоха механічних телевізорів підійшла до свого природного завершення лише в 1950-ті, остаточно поступившись місцем більш перспективним електронним пристроям. Інженери безперервно працювали над підвищенням якості зображення та зменшенням ваги телевізорів. А в 1954 році компанія RCA представила перший повноцінний телевізор із кольоровим зображенням. Утім, ці пристрої були занадто дорогими, дозволити собі таку покупку міг далеко не кожен.

Поступово з покращенням технологій виробництва та зниженням вартості кольорові телевізори стали доступнішими для широкого загалу. Варто зазначити, що остаточний перехід телестанцій на кольоровий формат мовлення відбувся лише до початку 1980-х років, а для багатьох людей кольоровий телевізор залишався технічною дивиною аж до початку 1990-х.

Наступним кроком у вдосконаленні телевізійних приймачів стало зменшення розмірів кінескопа та, відповідно, габаритів самого виробу. Ще 1964 року американці Дональд Бітцер, Джин Слоттоу та Роберт Вілсон розробили перші телевізори з плазмовими панелями (PDP). Однак втілити таку технологію в життя вдалося лише у 1980-х. Плаский екран із величезною діагоналлю, приголомшлива якість зображення, що досягається за допомогою іонізованого газу (плазми), широкі кути огляду та висока частота оновлення кадрів — усі ці переваги принесли плазмовим телевізорам шалену популярність серед покупців. Але були і свої недоліки: вищий рівень енергоспоживання, велика вага та обмежений термін служби. Тому вже до 2014 року виробництво таких панелей у всьому світі було припинено.

Наразі основними технологіями для телевізорів є рідкокристалічні дисплеї (LCD) та органічні світлодіодні дисплеї (OLED). Варто зазначити, що першопрохідником серед творців рідкокристалічних телевізорів стала японська фірма Casio, яка випустила подібні вироби на ринок ще 1983 року. А ось перші світлодіодні екрани з’явилися лише на початку 2000-х.

Попри те, що після появи OLED-технологія стикалася з певними обмеженнями, такими як короткостроковий термін служби світлових матеріалів і проблеми з рівномірністю світіння на великих площах, з часом і з покращенням технологій OLED-дисплеї стали все більш популярними і широко використовуються у сучасних пристроях, причому не тільки в телевізорах, а й у моніторах, смартфонах та інших гаджетах. Поліпшення у виробничих процесах та матеріалах дали змогу усунути багато початкових обмежень, і тепер OLED-дисплеї дають яскраві, контрастні зображення з відмінною кольоропередачею та швидким часом відгуку.

У 2015 році з’явилися перші смарт-телевізори, чи Smart-TV. Вони мають вбудований міні-комп’ютер, який дає змогу підключатися до Інтернету. Завдяки цьому смарт-телевізор можна використовувати для перегляду сайтів, запуску програм та ігор. Застосування великого екрану телевізора, по суті, як смартфона стало зручним і привабливим, тому на сьогодні смарт-телевізори переважають на ринку.

Наразі продовжується безперервне вдосконалення телевізійних технологій. Серед найперспективніших напрямків можна назвати такі:

- MicroLED-технологія — мікроскопічні світлодіоди забезпечують відмінну якість зображення, високу контрастність та тривалий термін служби;

- QLED (Quantum Dot LED) — для покращення кольоропередачі та яскравості зображення використовуються квантові точки;

- 8K-розділення — найвища якість зображення на сьогоднішній день серед усіх відомих форматів завдяки максимальній кількості пікселів (точок, які формують зображення на екрані);

- Гнучкі дисплеї, завдяки яким телевізор можна буквально згорнути в трубочку.

Ймовірно, у майбутньому телебачення еволюціонує в об’ємні голографічні зображення, які будуть більш реалістичними та привабливими для глядачів. При цьому такі зображення можна буде розглядати з різних боків і під різними кутами, одержуючи детальніше уявлення про предмет.

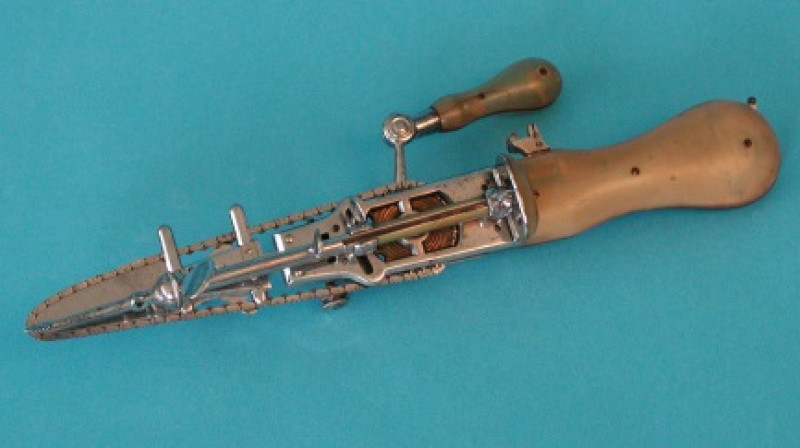

Прообраз ланцюгової пили — остеотом Бернарда Гайна

Перша бензопила Dolmar model A

Як зробити бензопилу легшою

1830 року німецький дантист-протезист Бернард Гайн придумав остеотом — хірургічний інструмент, який використовувався для розрізання кістки. Цей інструмент мав різальні зубці-ланки, скріплені між собою в ланцюг, який рухався за допомогою ручки-зірочки. Значного поширення інструмент не набув, оскільки одночасно обертати ручку та спрямовувати інструмент було вкрай незручно. Однак ідею запозичили власники тартаків. До початку XX століття були створені ланцюгові пилорами з ручним приводом. Такі махини були досить громіздкими і незграбними, а до роботи з ними залучали як мінімум двох осіб.

У 1926 році інженер-механік Андреас Штіль здогадався оснастити ланцюгову пилу електричним двигуном. Однак широкої популярності електропили на той момент не набули, оскільки досить легких та ефективних акумуляторів ще не існувало, а прив’язка до джерела електроживлення у багатьох випадках робила цей інструмент непрактичним.

1927 року німець Еміль Лерп використав замість електромотора компактний бензиновий двигун внутрішнього згоряння. Так було створено першу бензопилу. Двигун значно полегшував роботу лісозаготівельникам, проте розміри інструменту все одно були досить великими, а вага становила близько 60 кг. Лерп заснував компанію з випуску бензопил, які отримали назву Dolmar — на честь гори в Тюрінгії, де проходило перше випробування бензопили.

Компактна бензопила Dolmar CP, якою могла працювати одна людина, з’явилася в 1952 році. А в 1957 році ця ж пила отримала революційне технічне рішення, яке використовується в бензопилах досі. Це був мембранний карбюратор, який давав змогу експлуатувати пилу як у горизонтальному, так і у вертикальному положеннях.

У 1958 році брати Ганс і Гейнц Еммеріх установили на ланцюгову пилу двигун від мотообприскувача власного виробництва. Компанія Solo, заснована братами, була відома своїми розробками особливо компактних бензинових двигунів, тому нова ланцюгова пила вийшла дуже легкою, а отже дуже зручною.

1959 року компанія Андреаса Штіля розробила бензопилу без редуктора, що дало змогу ще дужче знизити масу інструменту. Того ж таки 1959 року на ринку бензопил з’явився новий сильний конкурент — шведська компанія Husqvarna — найстаріший європейський виробник. Уже в 1962 році Husqvarna розробила надлегку бензопилу Husqvarna 70, вага якої становила лише 5,5 кг. А в 1969 році була представлена ще одна інноваційна розробка — пила Husqvarna 180, створена за принципом двох мас і оснащена інтегрованою системою вібрації.

Конкурентна боротьба виробників бензопил сприяє активному розвитку технологій та розробці інноваційних рішень. Утім, сьогодні у пріоритеті екологічна ефективність, тому основні зусилля спрямовані на розробку екологічно чистих ручних інструментів зі зниженим рівнем шуму та кількістю шкідливих викидів.

У цьому аспекті перспективнішими є ланцюгові пили з електромоторами. Розвиток технологій акумуляторів та бездротового живлення лише сприяє цьому. Крім того, постійне вдосконалення конструкції, упровадження нових легких та міцних матеріалів, а також використання розумних технологій, таких як автоматичне регулювання обертів, датчики безпеки та системи запобігання нещасним випадкам, може зробити ланцюгові пили більш ергономічними, безпечними та зручними для користувачів.

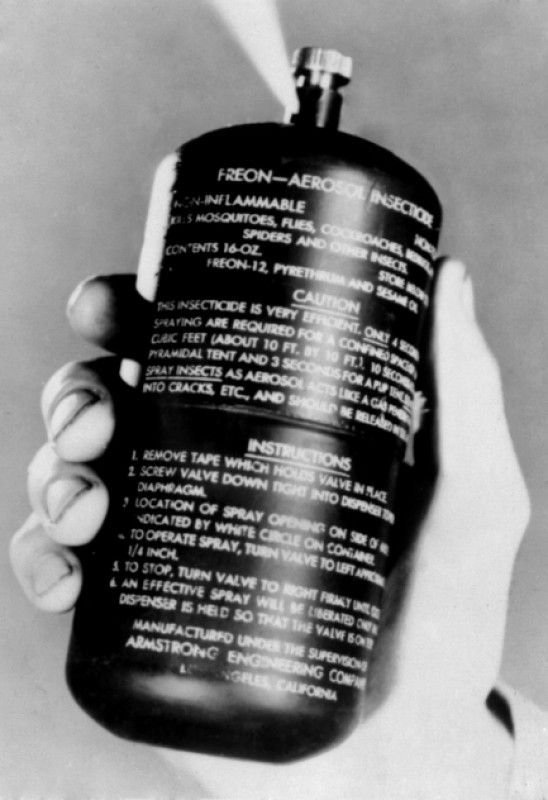

Перший аерозольний балон

Сучасні аерозольні балони

Що могли назвати «аерозольною бомбою»

Ще у XVIII столітті, коли Джозеф Прістлі відкрив спосіб отримання газованої води, було помічено явище виштовхування газованого напою з пляшки, у яку його налито. Інакше кажучи, рідина виштовхувалася з ємності за рахунок надлишкового тиску, створюваного розчиненим у ній газом.

У 1862 році було реалізовано ідею використання стисненого газу для розбризкування рідини. Однак сталеві ємності, які використовувалися з цією метою, були занадто громіздкими та незручними, тому великого успіху винахід не мав.

1927 року норвезький інженер-хімік Ерік Ротхайм отримав патент на перший аерозольний балон — ємність із клапаном, при відкритті якого з невеликого отвору виходить туманоподібна суміш рідини з газом — аерозоль.

Довгий час винахід Ротхайма не мав практичного застосування, і лише 1943 року американці Лайл Гудхью та Вільям Салліван здогадалися використовувати балон для боротьби з комахами. Їхня «аерозольна бомба» була невеликою сталевою посудиною, за допомогою якої солдати могли захищатися від переносників малярії — комарів, розпирскуючи вміст балона всередині наметів і літаків. Для розпилення використовувався зріджений газ фторвуглець, який згодом став успішно застосовуватися в інших аерозольних балонах (наприклад, з лаком для волосся).

У 1949 році власник механічного цеху в Бронксі Роберт Абпланальп розробив так званий обтискний клапан, який досі використовується для управління розпиленням в аерозольних балончиках. Винахід Абпланальпа з легкого алюмінію зробив банки дешевим і практичним способом дозування рідких пін, порошків і кремів. Заснована винахідником компанія незабаром заробила понад 100 мільйонів доларів, виробляючи понад мільярд аерозольних балонів на рік.

У 1974 році хіміки Френк Шервуд Роуленд і Маріо Моліна припустили, що хлорфторвуглеці (ХФВ), які використовуються як газове середовище в аерозольних розпилювачах, сприяють стоншенню озонового шару Землі. А наукове обґрунтування цього вдалося надати лише 1985 року. Тоді ж було прийнято Віденську конвенцію про охорону озонового шару Землі, а через два роки було офіційно підписано Монреальський протокол, який регулює виробництво ХФВ. У відповідь на це виробники аерозольних балонів почали використовувати водорозчинні вуглеводні, безпечні для довкілля, і продукція продовжила своє тріумфальне поширення світом.

Сьогодні аерозольні балони мають найрізноманітніше застосування. Вони широко використовуються в косметичній індустрії та медицині. З їх допомогою розпорошуються засоби побутової хімії: препарати для чищення, ароматизатори повітря, знежирювачі. Аерозолі є чудовим способом нанесення будівельних та промислових матеріалів, наприклад, фарб, клею, мастил. У майбутньому затребуваність аерозольної упаковки буде тільки зростати, при цьому значна увага приділятиметься екологічності та безпеці балонів.

Антибіотики

«Проти життя»

Відомо, що ще жителі Стародавнього Єгипту, Китаю та Індії використовували запліснявілий хліб для лікування ран і гнійників. Відповідні згадки про застосування плісняви з лікувальною метою часто зустрічаються в працях давніх учених і філософів, написаних понад дві тисячі років тому. Нубійські мумії, виявлені на території Південного Єгипту та досліджені в 1990-х роках, добре збереглися завдяки значному вмісту тетрацикліну, джерелом якого в давнину могло бути пиво.

Докладно вивчати лікувальні властивості плісняви стали лише на початку 1870-х років. У 1877 році мікробіологи Луї Пастер і Роберт Кох помітили, що одна з бактерій здатна пригнічувати зростання іншої. Це явище отримало назву «антибіоз» — у перекладі з грецької «проти життя». Приблизно в той самий час німецький лікар Пауль Ерліх висунув ідею про створення хімічних речовин, які діятимуть як вибіркові ліки, вбиваючи шкідливі бактерії та не завдаючи при цьому шкоди людському організму. Згодом такі речовини одержали назву «антибіотики». Утім, перш ніж це сталося, сплило ще чимало часу.

Дослідження тривали протягом десятиліть. Різним ученим удалося довести ефективність пліснявих грибів проти збудників таких страшних захворювань, як сибірка або черевний тиф. Але виділити стабільний препарат на основі плісняви тривалий час не виходило.

Британський мікробіолог Александр Флемінґ ще під час Першої світової війни зіткнувся з проблемою інфікування ран і зрозумів, що терміново потрібні ефективніші антибактеріальні засоби, ніж ті, що використовувалися для лікування на той час. Взявши за основу роботи Луї Пастера, Флемінґ розпочав дослідження.

У 1928 році, проводячи нічим не примітний експеримент із хвороботворними бактеріями, учений несподівано відкрив спосіб виділення із пліснявого гриба Penicillium notatum речовини, що вбиває бактерії. Мабуть, пеніциліум знайомий кожному — саме цей грибок покриває зачерствілий хліб зелено-білими плямами. Випадково потрапивши на колонію хвороботворних бактерій-стафілококів, пліснявий грибок виділив речовину, яка їх знищила. Флемінґу вдалося зібрати цю речовину, яку він назвав пеніциліном на честь того самого грибка.

Цікаво, що відкриття Флемінґа не викликало серед медиків великого ентузіазму. Річ у тім, що виявлена речовина виявилася дуже нестійкою і руйнувалася навіть протягом короткочасного зберігання. Тільки в 1938 році двом ученим з Оксфордського університету, Говарду Флорі та Ернсту Чейну, удалося вирішити проблему стійкості, отримавши сіль пеніцилінової кислоти. Почалося масове виробництво пеніциліну, завдяки якому під час Другої світової війни було врятовано сотні тисяч людських життів у всьому світі. У 1945 році Говард Флорі, Александр Флемінґ та Ернст Борис Чейн отримали Нобелівську премію з медицини «За відкриття пеніциліну та його цілющого впливу при різних інфекційних хворобах».

Слідом за пеніциліном були відкриті й інші антибактеріальні засоби. Саме в цей період американський біохімік українського походження Зельман Ваксман запропонував називати антибіотиками будь-які речовини, вироблені живими мікроорганізми, які перешкоджають зростанню інших мікроорганізмів. До речі, 1952 року Ваксман отримав Нобелівську премію з медицини за відкриття стрептоміцину — першого препарату, ефективного при лікуванні туберкульозу.

Наразі термін «антибіотик» застосовується до будь-яких ліків, які вбивають бактерії або пригнічують їх зростання, незалежно від того, чи виробляються ці ліки мікроорганізмом, чи ні. Це пов’язано з тим, що з часом подібні препарати навчилися отримувати штучно. Синтетичні антибіотики мають підвищену ефективність завдяки подоланню опору бактерій природним антибіотикам.

У середині XX століття кількість нових антибіотиків, запроваджених для медичного застосування, значно зросла. З 1940 до 1968 року було відкрито понад 20 класів цих препаратів, після чого темпи помітно знизилися. Пов’язано це з тим, що, попри важливість у лікуванні інфекцій, застосування антибіотиків має і негативний аспект: шкідливі мікроорганізми мутують і стають несприйнятливими до впливу таких речовин.

Тому нині зусилля вчених спрямовані на розробку інноваційних підходів до лікування інфекцій. Перспективними є дослідження у сфері генетичної інженерії, що дає змогу створювати модифіковані антибіотики або вдосконалені версії вже наявних для підвищення їх ефективності. Крім того, розробляються методи використання бактеріофагів — вірусів, які знищують бактерії. Застосування нанотехнологій для створення наночастинок, що мають антибактеріальні властивості, також є перспективним напрямом.

Перша електрична бритва Джейкоба Шика

Роторна електробритва типу Philishave

Сіткова електробритва

Уперше ідея голитися за допомогою електричного пристрою спала на думку інженеру-будівельнику з Нью-Йорка Джону Френсісу О’Рурку. Він навіть отримав відповідний патент у 1898 році, але діючої електробритви винахідник так і не створив.

Американський офіцер Джейкоб Шик ще 1910 року, коли шукав золото на Алясці, замислився над створенням бритви, яка була б ефективною навіть за відсутності гарячої води. Для сухого гоління він вирішив використати пристрій із електромоторчиком і навіть накидав його ескіз.

Після Першої світової війни Шик вирішив втілити свою ідею в життя. А щоб накопичити для цього достатньо коштів, почав удосконалювати звичайні безпечні бритви. Будучи військовим, Шик надихнувся гвинтівкою з магазином, тому його бритви відрізнялися від усіх інших тим, що змінні леза продавалися в затискачах, які можна було вставляти в бритву, не ризикуючи порізатися. Таке доопрацювання сподобалося багатьом покупцям, і Шику вдалося зібрати достатньо коштів, щоб реалізувати свій давній задум і створити електробритву — у листопаді 1928 він здобув патент на свій винахід, а ще через рік налагодив масовий випуск.

У 1937 році голландський інженер-механік Александр Горовіц із лабораторії Philips у Нідерландах винайшов конструкцію роторної електробритви. У обертового ножа в такій бритві було не одне, а три леза. Прорізів у голільній голівці стало значно більше — бритва перестала «видирати» волосся. Такий тип електробритв отримав назву Philishave і згодом став найпоширенішим завдяки своїй простоті, надійності та ефективності. Згодом з’явилися прилади з двома і трьома голільними голівками, а в деяких сучасних моделях їх цілих п’ять!

Наприкінці 1940-х років з’явилися перші бездротові електробритви. Автономна система була дуже зручною, наприклад, для подорожей. Спочатку для живлення невеликого електродвигуна використовувалися батарейки, але вже в 1960 році компанія Remington випустила бритву, яка могла працювати як від акумуляторів, так і від мережі (при цьому акумулятори заряджалися).

У 1950 році Макс Браун представив громадськості свій винахід — електробритву сіткового типу. Особливість цього пристрою полягала в тому, що його нерухомий ніж був виконаний у формі сітки, вигнутої дугою. При цьому така металева сітка покривала всю площу голільної голівки бритви, а всередині до неї прилягав рухомий ніж. У процесі роботи він переміщався від одного краю до іншого і таким чином обрізав волосинки. Бритва непогано голила і, що важливо, на відміну від роторних бритв тих часів, не викликала подразнення шкіри.

У другій половині XX століття широке застосування пластмас дало змогу виробляти стильні дизайнерські форми бритв яскравих кольорів. Потужні електродвигуни дозволили використовувати більше різальних лез. Якоїсь миті навіть з’явився розподіл електробритв на чоловічі та жіночі.

Значний внесок у розробку електробритв зробив Роланд Ульманн. Він першим поєднав гумові та металеві елементи в бритвах, а загалом за свою кар’єру подав понад 100 патентів на різні інновації у бритвах сухого типу.

До речі, ранні версії електробритв призначалися виключно для гоління сухої шкіри. Але сучасні електробритви підходять і для «вологого» використання, що дозволяє чистити їх проточною водою, а також поєднувати з різними засобами для гоління, що зволожують шкіру та запобігають її травмуванню.

Наразі великі виробники безперервно удосконалюють конструкцію своїх електробритв, реалізуючи інновації в нових моделях кожні кілька років. Поліпшуються системи лез, вбудовуються інтелектуальні сенсори, які допомагають інтегрованому штучному інтелекту адаптувати гоління до особливостей шкіри користувача, впроваджуються більш енергоефективні системи живлення. Крім того, електробритви можна буде інтегрувати з іншими пристроями та технологіями, наприклад зі смартфонами, для надання розширених функцій та можливостей управління.

Овочечистка L’Économeр

Овочечистка Sparschäler Rex

Овочечистка Jonas

Покращений кухонний ніж, що став символом Швейцарії

Якщо ви думаєте, що у XX столітті винаходили тільки якісь високотехнологічні пристрої, які стали можливими лише з останніми досягненнями тогочасної науки, ви помиляєтеся. 1929 року у Франції була вигадана овочечистка (ніж для очищення картоплі, або пілер, як ще називають цей нехитрий, але, безперечно, корисний девайс). Створив цей інструмент майстер ножів Віктор Пузе. Новинка продавалася під товарною назвою L’Économee (у перекладі з французької — ощадливий) і рекламувалася як «покращений кухонний ніж», який дасть змогу заощадити 30% як часу, так і картоплі.

А 1947 року Альфред Невечерзаль створив знамениту швейцарську овочечистку Sparschäler Rex із поворотним ножем, завдяки якому кут леза автоматично регулюється під натиском. Конструкцію саме цієї овочечистки покладено в основу найпопулярніших на сьогоднішній день пілерів з Y-подібною ручкою.

До речі, Sparschäler Rex стала одним із символів Швейцарії разом із годинником та армійським ножем, тому 2004 року її навіть зобразили на швейцарській поштовій марці.

У 1953 році у Швеції дизайнер Джонас розташував поворотний ніж не поперечно, як у швейцарській овочечистці, а поздовжньо, як у звичайному ножі. Таким чином інструмент поєднав у собі найкращі якості всіх попередніх овочечисток.

Примітно, що на підприємствах громадського харчування та невеликих овочепереробних виробництвах картоплю та інші овочі давно не чистять вручну ні звичайними ножами, ні пілерами. Для цього використовуються спеціальні машини, що складаються з резервуару зі стінками, покритими крупнозернистим шліфувальним каменем. У резервуар засипається нечищена картопля і додається певна кількість води, після чого електродвигун починає обертати резервуар разом із його вмістом, і шкірка в процесі тертя картоплин об камінь зчищається у вигляді пасти. Очищена картопля висипається з пристрою крізь спеціальну заслінку.

Крім того, для очищення овочів у промислових умовах їх можуть попередньо обробляти струменями пари або лугом, щоб пом’якшити зовнішню оболонку, після чого механічно видаляють шкірку за допомогою барабанних агрегатів із дископодібними шипами різного розміру.

Цілком можливо, що в майбутньому для процесу очищення овочів будуть застосовуватися механічні пристрої нового типу, керовані штучним інтелектом, завдяки чому процес видалення шкірки стане ще швидшим та ефективнішим.

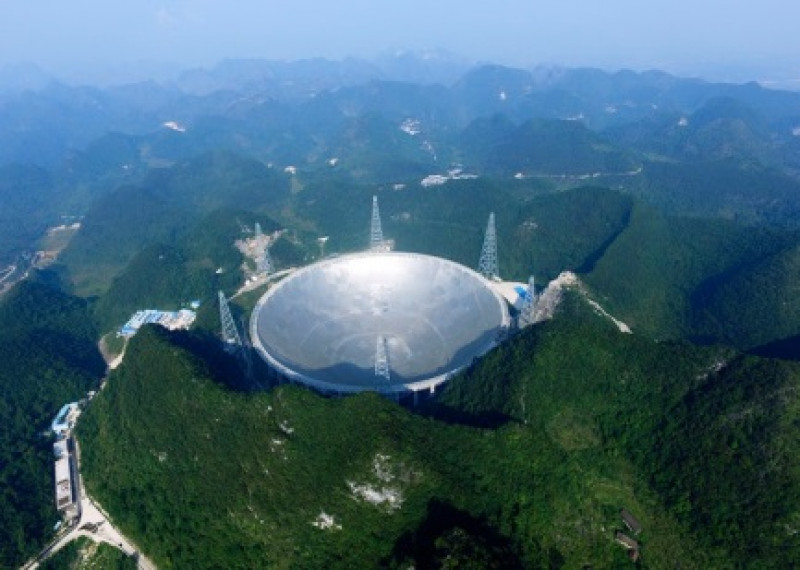

Найбільший радіотелескоп

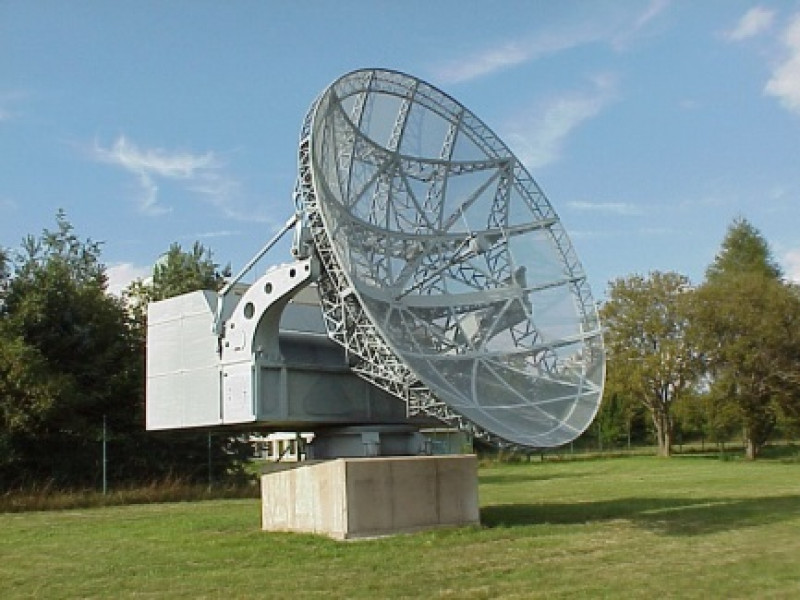

Сонце випромінює радіоперешкоди?

Наприкінці ХІХ століття вчені висловили припущення, що небесні тіла — зірки та планети — можуть випускати не лише видимі людським оком світлові хвилі, але й інші види випромінювань, зокрема радіохвилі. У 1890-ті роки Едісон у США та Лодж у Великій Британії незалежно один від одного намагалися провести досліди щодо виявлення радіовипромінювання Сонця. Але на той момент досить чутливих приймачів ще не існувало, тому жодних результатів досягти не вдалося.

Коли ж у 1902 році було відкрито іоносферу — верхню частину шарів атмосфери, яка відбиває радіовипромінювання, — фізики дійшли висновку, що вона відбиватиме будь-які астрономічні радіохвилі назад у космос, тому виявити їх неможливо.

1931 року американський радіоінженер Карл Янський вирішував цілком практичне завдання — як позбутися перешкод у радіоефірі під час грози. Він досліджував напрямки приходу грозових перешкод і побудував з цією метою вертикально поляризовану односпрямовану антену 30,5 метра завдовжки та 3,7 метра заввишки. До основи антени кріпилися чотири колеса, завдяки чому її можна було повертати врізнобіч. Антена була з’єднана з чутливим приймачем, на виході якого стояв реєструвальний пристрій — самописець.

Провівши перші досліди зі своєю установкою, Янський виявив «постійне шипіння невідомого походження». Спочатку дослідник вирішив, що ці шуми пов’язані з апаратурою — навушниками або іншими компонентами обробки вхідних сигналів. Однак потім він переконався, що напрям, з якого приходять перешкоди у вигляді шипіння, поступово змінюється протягом дня, роблячи повний оберт за 24 години. Таким чином Янський зробив висновок, що причиною перешкод є Сонце.

Продовжуючи дослідження, учений поступово дійшов висновку, що джерелом його нових перешкод є центральна область нашої галактики, причому найбільший відгук виходить, коли антена спрямована до центру Чумацького Шляху.

Янський розумів, що для точніших і достовірніших вимірювань знадобляться антени більших розмірів та з чутливішими датчиками. Причому ці антени мають бути легко орієнтовані в різних напрямках.

Він навіть розробив конструкцію параболічної антени діаметром 30,5 метра, проте його ідея не знайшла підтримки у науковому світі, і радіоастрономія на цьому етапі не почала розвиватися. Сам Янський був призначений на інший проєкт, тому продовжувати дослідження в галузі астрономії він більше не міг.

У 1937 році радіоінженер та астроном-аматор Ґроут Ребер, натхненний роботою Янського, побудував у себе на задньому дворі параболічний радіотелескоп діаметром 9 метрів. Розпочавши з повторення спостережень свого попередника, він провів перший огляд неба в радіочастотах. Йому вдалося створити карту неба в радіодіапазоні, на якій чітко видно центральні ділянки Чумацького Шляху та вперше виявлені яскраві радіоджерела — галактики Лебідь А та Кассіопея А. Літера А у назві цих астрономічних об’єктів указує на те, що вони є так званими радіогалактиками — потужними джерелами радіовипромінювання у своїх сузір’ях. До речі, Ребер відкрив ці радіогалактики задовго до того, як їх вдалося виявити візуально за допомогою оптичних телескопів. Крім того, карти Ребера досить хороші навіть у порівнянні з сучасними, складеними за допомогою значно досконалішого обладнання.

У 1940-ві роки різним радіоінженерам вдалося виявити і точно ідентифікувати радіохвилі, випромінювані Сонцем. Однак через заходи секретності, пов’язані з використанням радарів під час війни, про це відкриття деякий час не оголошувалося широкому загалу. Одначе, швидкий розвиток радіолокації привів до створення технологій, які після війни були з успіхом застосовані в радіоастрономії, давши потужний поштовх цьому напрямку космічних досліджень.

У 1950-ті роки різні університети й дослідницькі інститути почали створювати великі радіотелескопи, і незабаром величезні тарілки антен з’явилися в різних куточках нашої планети. Широкий діапазон довжин радіохвиль, велика кількість об’єктів досліджень, швидкі темпи розвитку радіофізики та велика кількість незалежних колективів радіоастрономів дали поштовх до появи значного розмаїття типів радіотелескопів. Найбільш дивовижними були конструкції, які використовували природний рельєф як дзеркало антени.

Так, 2016 року в Китаї було здано в експлуатацію радіотелескоп FAST «Небесне око» з гігантською тарілкою діаметром аж 500 метрів!

У сучасному світі радіотелескопи відіграють ключову роль у наукових дослідженнях, астрономії та космології. З їх допомогою вчені отримують інформацію про склад, структуру та динаміку зірок, галактик, квазарів, пульсарів та інших космічних об’єктів. Радіотелескопи використовуються для визначення координат та руху небесних тіл, для вивчення вибухів наднових, визначення магнітних бур на Сонці, сплесків гамма-променів та збору даних про міжзоряний простір.

Крім того, саме радіотелескопи відіграють ключову роль у проєктах із виявлення позаземних цивілізацій — з їхньою допомогою відбувається пошук радіосигналів від можливих інопланетних рас, а також передаються закодовані повідомлення про нашу цивілізацію.

Крім того, технології, розроблені для радіотелескопів, також знаходять застосування в галузі комунікацій та передачі даних, зокрема в бездротових технологіях, супутниковому зв’язку тощо. Радіотелескопи надихають нове покоління вчених та інженерів, будучи частиною освітніх програм та наукових заходів.

Електронний мікроскоп

Як побачити предмети, розміри яких менші за довжину хвилі світла

Відтоді як наприкінці XVI століття було винайдено мікроскоп, цей пристрій постійно вдосконалювався, даючи вченим змогу здійснювати все нові і нові відкриття в мікросвіті. На середину ХІХ століття розвиток оптики давав змогу робити мікроскопи з досить значним збільшенням. Однак у 1873 році німецький фізик Ернст Аббе висловив припущення, що для оптичних мікроскопів існують певні межі їхніх можливостей, а саме — об’єкти, розміри яких менші за довжину хвилі світла (а це приблизно кілька сотень нанометрів) буде просто неможливо розрізнити за допомогою мікроскопів видимого світла.

Намагаючись вирішити цю проблему, інші німецькі вчені-оптики Келер і Рор розробили ультрафіолетовий мікроскоп, що дало змогу збільшити роздільну здатність удвічі. Однак навіть їхній пристрій, який використовував дорогу кварцову оптику, був обмежений довжиною хвилі ультрафіолету.

Водночас у 1858 році фізик Юліус Плюккер відкрив відхилення електродів (катодних променів, як він їх називав) магнітними полями. Цей ефект у 1897 році використав Фердинанд Браун для створення вимірювального пристрою — електронно-променевого осцилографа (CRO).

Інший фізик-експериментатор, Едуард Рікке, виявив, що електрони можна фокусувати за допомогою магнітних полів, що дало змогу створити просту конструкцію електромагнітної лінзи. Розвиваючи цю ідею, послідовник Рікке фізик Ганс Буш у 1926 році довів, що рівняння оптичних лінз за певних припущень можна застосувати до електронів.

Дослідницька група Берлінського технічного університету під керівництвом Макса Кнолля, працюючи над удосконаленням електромагнітних лінз із метою створення більш якісного електронно-променевого осцилографа, 1931 року створила перший електронний мікроскоп — пристрій з електростатичними лінзами, де як джерело освітлення використовується не світловий промінь, а пучок електронів. Оскільки довжина хвилі електрона може бути у 100 000 разів менша, ніж у видимого світла, електронні мікроскопи здатні розрізняти об’єкти, розміри яких становлять близько 0,1 нм.

Згодом конструкція електронних мікроскопів безперервно оптимізувалася, а електронна мікроскопія знаходила своє застосування у нових сферах людської діяльності. Особливо інтенсивно електронні мікроскопи поширювалися після Другої світової війни. Створені тоді розробки із багатоступінчастою оптикою досі використовуються в сучасних мікроскопах. Перша міжнародна конференція з електронної мікроскопії відбулася 1949 року в нідерландському Делфті. На ній були присутні більше ста людей з різних країн.

З розвитком просвічувальних електронних мікроскопів у 1970-ті роки була досліджена та доопрацьована методика сканувальної просвічувальної електронної мікроскопії. Альберт Крю з університету Чикаго створив автоемісійну гармату, за допомогою якої йому вдалося отримати зображення атомів.

Поява електронних мікроскопів відіграла важливу роль у розвитку таких наук, як мікробіологія, матеріалознавство та нанотехнології. За допомогою цих пристроїв вчені змогли розглянути найменші деталі структури клітин, бактерій, вірусів, молекул і навіть атомів. Наразі електронні мікроскопи широко використовуються в наукових цілях, допомагаючи краще розуміти світ на мікро— та нанорівнях. Вони можуть ставати частиною ширших технологічних комплексів, зокрема системи наноаналізу, спектроскопії та навіть штучного інтелекту для автоматичного дослідження даних.

Водночас електронні мікроскопи продовжують удосконалюватися. Розвиток технологій та методів обробки зображень, таких як абераційна корекція та комп’ютерна томографія, може привести до додаткового підвищення роздільної здатності електронних мікроскопів. Це дасть змогу дослідити об’єкти на ще меншому масштабі та розширить можливості в нанотехнологіях, біології й матеріалознавстві.

Удосконалення програмного забезпечення та методів візуалізації дозволяє більш ефективно обробляти та інтерпретувати дані, отримані з електронних мікроскопів, що своєю чергою полегшить дослідження та освітні процеси. При цьому вартість таких пристроїв стає дедалі доступнішою для широкого кола дослідників, зокрема малих лабораторій та освітніх установ.

Електронні мікроскопи можуть стати частиною інтегрованих систем сканування та 3D-моделювання об’єктів, що дасть змогу більш повно й точно вивчати їх структуру та форму. Також на електронні мікроскопи можуть вплинути квантові технології, відкриваючи нові можливості для дослідження й візуалізації об’єктів на рівні окремих квантів.

Надалі електронні мікроскопи будуть усе більш ефективними й функціональними інструментами для наукових досліджень у різних галузях.

Найлегший із твердих матеріалів — аерогель

З чого можна зробити тканину, ковдру та… вибухівку?

У 1931 році хімік Стівен Кістлер з Тихоокеанського коледжу в Каліфорнії відкрив новий матеріал, який отримав назву «аерогель».

Слід зазначити, що звичайний гель (від латинського gelo — застигаю) — це така змішана структура, у якій одна тверда речовина поєднується з іншою рідкою речовиною. При цьому тверда речовина утворює так звану матрицю, а рідка цю матрицю заповнює. У результаті гелі, не будучи твердими тілами, мають їх властивості: не течуть, можуть зберігати форму, здатні до деформації.

У своїх дослідах Кістлер замінив рідину в гелі на метиловий спирт, після чого нагрів гель під тиском до повного випаровування спирту. При цьому гель «висихав», майже не стискаючись, а його матриця заповнювалася повітрям (звідки й назва матеріалу: «аерос» у перекладі з грецької — повітря). Отриманий матеріал мав рекордно низьку щільність і демонстрував цілу низку унікальних властивостей: твердість, прозорість, жаростійкість, надзвичайно низьку теплопровідність.

Що важливо, аерогелі можна робити буквально з усього, що «лежать під ногами»: піску, глиноземів, оксидів металів. А на початку 1990-х було отримано перші зразки аерогелю на основі вуглецю.

На дотик аерогелі нагадують легку, але тверду піну. При сильному навантаженні аерогель може тріскатися, але в цілому це вкрай міцний матеріал, який витримує навантаження в тисячі разів більші за власну вагу. Завдяки високому вмісту повітря цей матеріал є дуже хорошим утеплювачем.

Як правило, аерогелі напівпрозорі та залежно від матеріалів, із яких вони складаються, можуть мати різні кольори. Однак є також зовсім непрозорі аерогелі. Наприклад, вуглецеві, які мають глибокий чорний колір і поглинають 99,7 % світла, що падає на них.

Наразі ця речовина використовується для різних цілей. Аерогель — це:

- чудовий матеріал для тепло— та звукоізоляції у будівництві чи промисловості;

- хімічний адсорбер, який використовується для очищення стічних вод;

- носій хімічного каталізатора, наприклад, у вихлопних системах автомобілів;

- основа для міцних тканин одягу й ковдр;

- матеріал для фізичних досліджень і дослідів.

Із аерогелів на основі кремнезему виробляють оптоволокно. Окремі види аерогелів можуть бути вибухівкою.

А ще аерогель є ключовим матеріалом у космічному проєкті «Стардаст», де він використовується для збирання космічного пилу — найдрібніших частинок, які перебувають у космосі та складаються буквально з кількох молекул.

Унікальні властивості аерогелів підходять для виконання найширшого кола завдань, а з розвитком технологій сфери застосування подібних матеріалів будуть тільки примножуватися.

Як з’явилися трамполіни для тренування пілотів, штурманів і космонавтів

У північних народів існувала традиція — під час весняного свята вполювання китів танцюристів підкидали у повітря за допомогою натягнутої шкіри моржа. Існують свідчення, що схожі звичаї були в давнину і в європейців, тільки в них для цього кілька людей розтягували велику ковдру.

Наприкінці XIX століття, а саме в 1887 році, натягнуті ковдри здогадалися використовувати пожежники, щоб упіймати людей, які, рятуючись від вогню, вистрибують із вікон палаючих будівель. Звучить неймовірно, але коли в усьому світі вже плавали пароплави, ходили потяги, їздили перші автомобілі, а на фабриках і заводах працю людини успішно замінювали потужні парові машини, двигуни внутрішнього згоряння і навіть перші електромотори, люди все ще не придумали такої простої розваги, як стрибки на пружній поверхні, що підкидає в повітря!

Утім, за деякими відомостями, у XIX столітті так звані стрибучі ліжка використовували циркові акробати для безпеки і для того, щоб здивувати глядачів. Навіть існує легенда, що перший батут придумав ще в Середні віки цирковий акробат на ім’я Дю Трамполіне (англійська назва батута — Trampoline — нібито походить саме звідти), проте жодних достовірних підтверджень цього не існує.

Зате достеменно відомо, що перший сучасний батут був побудований 1935 року чемпіоном зі стрибків у воду та акробатичних стрибків Джорджем Ніссеном. З’єднавши за допомогою еластичних джгутів частину полотна із шарнірною металевою конструкцією, він отримав пристрій, який спочатку застосовувався для тренування акробатів, але незабаром завоював популярність і в інших сферах. Назву «трамполін» Ніссен взяв з іспанської мови, де це слово означає трамплін для стрибків у воду. А звичніше для нас слово «батут» походить від італійського battuta — удар.

У 1942 році Ніссен спільно з гімнастом Ларрі Ґрісволдом створили компанію «Ґрісволд-Ніссен Батут та Акробатика» (The Griswold-Nissen Trampoline & Tumbling Company) і почали комерційно виробляти батути.

Спочатку передбачалося, що батут використовуватиметься виключно для розваг та відпочинку. Ніссен навіть вигадав першу гру на батутах — Spaceball («Космічна куля»). Для цього ігровий майданчик був обладнаний кількома батутами та сіткою, з різних боків якої розташовувалися команди гравців. Завданням команд було перекинути м’яч через сітку на поле суперників — такий собі волейбол зі стрибунами.

Однак під час Другої світової війни льотна школа ВМС США почала використовувати батут для тренування пілотів і штурманів, розвиваючи в них здатність краще орієнтуватися у просторі. Через десятиліття аналогічним способом тренували перших космонавтів, даючи їм досвід зміни положень тіла в польоті.

І, звісно, не можна не згадати про роль батута у створенні окремого виду спорту. 1964 року відбувся перший чемпіонат світу зі стрибків на батуті, а з 2000 року ця дисципліна стала частиною Олімпійських ігор. На сучасному батуті для змагань досвідчений спортсмен може підстрибувати на висоту до 10 метрів, виконуючи кілька сальто і поворотів. Міні-батути діаметром близько одного метра зараз часто використовують для фізичних тренувань. А спеціальні батути, обладнані з боків захисною сіткою, є улюбленою розвагою для дітей.

За принципом кажана, або Що могли назвати телемобілоскопом

Наприкінці ХІХ століття фізик Генріх Герц виявив, що радіохвилі відбиваються від металевих предметів. Це привело вчених до думки, що можна створити пристрої, які могли б випускати радіохвилі в певному напрямку, а потім, коли ці хвилі відіб’ються від того чи іншого об’єкта, знову вловлювати їх і таким чином визначати відстань до цього об’єкта. До речі, подібним чином у просторі орієнтуються кажани. Щоправда, замість радіохвиль вони випускають ультразвук, а потім уловлюють вухами його відбиття від перешкод.

Перші прилади, які використовували принцип відбиття радіохвиль у своїй роботі, з’явилися на початку ХХ століття. У 1904 році німецький винахідник Крістіан Гюльсмейєр створив простий пристрій виявлення кораблів, призначений для запобігання зіткненням у тумані. Свою систему радіолокації, названу телемобілоскопом, Гюльсмейєр представив німецьким військовим чиновникам, але ті з якихось причин її відхилили.

Утім, для створення повноцінного радіолокатора (тобто пристрою, здатного визначати положення об’єктів за допомогою радіохвиль) інженерам належало винайти ще безліч важливих і дотепних технічних пристроїв і приладів: магнетрони, клістрони, лампи з рухомою хвилею, хвилеводи, підсилювальні та генераторні лампи складної конструкції.

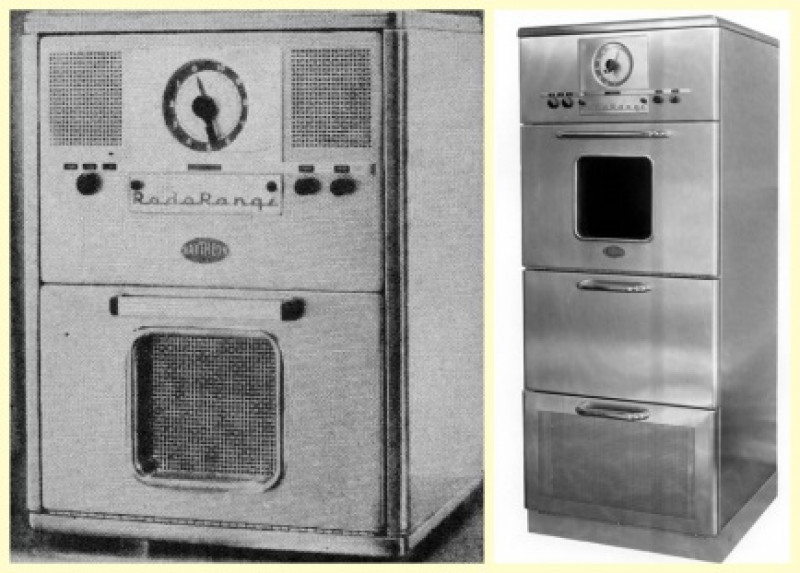

Перший повноцінний радіолокаційний пристрій 1935 року створив американець Роберт Пейдж, який працював у Військово-морській дослідній лабораторії США. До речі, саме американська назва розробки radio detection and ranging — радіовиявлення та вимірювання дальності — пізніше скоротилася до radar і була прийнята в усьому світі. Слідом за американцями свої радіолокаційні системи продемонстрували Рудольф Кюнгольд із Німеччини та Роберт Ватсон-Ватт із Великої Британії.

Істотний прогрес у вдосконаленні систем радіолокації відбувся під час Другої світової війни. Значно прискорилися дослідження щодо пошуку кращої роздільної здатності, більшої портативності й підвищення кількості функцій для радарів. Було розроблено легкі комплекти для оснащення нічних винищувачів та морських патрульних літаків, а також додаткових навігаційних систем. До кінця військових дій усі учасники конфлікту мали широкий спектр радарів наземного і морського базування, а також невеликих авіаційних бортових систем.

Після війни використання радарів поширилося на численні сфери діяльності: цивільну авіацію, морську навігацію, поліцію, метеорологію та навіть медицину. Подальший розвиток радіолокації був спрямований на постійне збільшення частоти радіохвиль, що забезпечувало більш високу роздільну здатність та точність виявлення об’єктів. Крім того, великий вплив на використання радарів мала обробка їхніх сигналів комп’ютерами, що значно збільшило можливості цих приладів.

Нині радари стали невід’ємною частиною повсякденного життя. Вони широко використовуються в автомобілях, літаках та кораблях для виявлення перешкод та інших транспортних засобів, прогнозують погодні умови та допомагають уникнути потенційно небезпечних ситуацій, запобігаючи зіткненням та аваріям. Військові за допомогою радарів виявляють та перехоплюють ворожі літаки й ракети, а також відстежують повітряні, наземні й морські об’єкти. У медицині за допомогою радарів створюються зображення внутрішніх органів людини. А в промисловості радари використовують для контролю виробничих процесів, моніторингу рівнів рідини, вимірювання швидкості й напрямку руху об’єктів.

Загалом радари є важливим інструментом для гарантії безпеки, підвищення комфорту й ефективності різних процесів. Поява нових технологій дає змогу безперервно вдосконалювати радари, роблячи їх більш чутливими та підвищуючи дальність виявлення, при цьому пристрої стають все більш компактними й надійними. Значно розширити функціональність та ефективність радіолокаційних систем може їхня інтеграція зі штучним інтелектом. Крім того, саме радари відіграють ключову роль у розвитку безпілотних автомобілів та роботизованих систем.

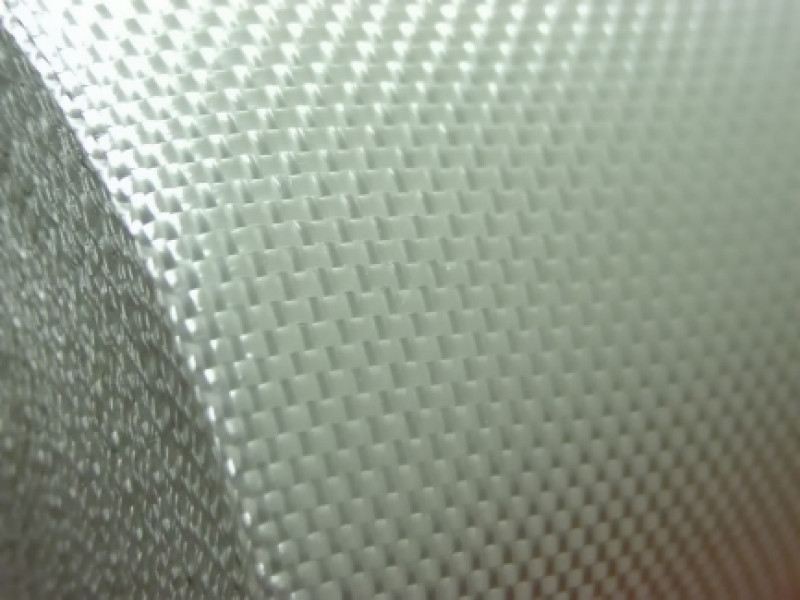

Скловолокно

Композитні матеріали в Композитний вік

Ще стародавні єгиптяни та фінікійці, виплавляючи скло із суміші піску, вапна й соди, отримували скляні волокна — окремі волоски. Якоїсь користі вони не мали та застосовувалися виключно для прикрас.

Через кілька тисячоліть, у 1870 році Джон Плеєр розробив метод масового отримання скляного волокна з використанням подачі струменя пари під тиском. У результаті він винайшов скловату — матеріал, який досі широко використовується як ефективний утеплювач у будівництві та промисловості. 1880 року Герман Хаммесфар отримав патент на тканину зі скловолокна з шовковими вплетіннями. Однак технології того часу не дозволяли зробити скляні волокна досить тонкими, щоб вони добре гнулися, тому реалізувати ідею на практиці винахіднику не вдалося.

Сучасний метод отримання скловолокна 1938 року відкрив Дейл Клейст, причому цілком випадково. Намагаючись з’єднати два скляні блоки, щоб зробити повітронепроникний затвор, дослідник вдарив струменем стисненого повітря в потік розплавленого скла, створивши справжній фонтан із тонких скляних волокон. Клейст узяв пістолет для напилення бронзи на різні поверхні й заповнив його замість бронзи розплавленим склом. У результаті пістолет випустив сніп найтонших ниткоподібних волокон, із яких згодом була створена перша склотканина — міцний і довговічний вогнетривкий матеріал.

Приблизно в цей час Карлтон Елліс запатентував технологію отримання поліефірної смоли. Цей винахід можна вважати точкою відліку в розвитку композитних матеріалів, перші з яких були отримані змішуванням скловолокна і смоли.

Склотканині можна легко надати необхідної форми, після чого залити поліефірною смолою. Після застигання смола забезпечує структурну цілісність і форму композиту, а скловолокно відіграє армувальну роль — надає міцніості і жорсткості конструкції завдяки своїй стійкості до розтягнення. Таким чином, деталі зі скловолокна зі смолою виходять легкими, але надзвичайно міцними.

Перші кроки у розвитку композитних технологій із використанням скловолокна робилися під час Другої світової війни, зокрема у 1942 році в США з нього виготовляли перші окремі деталі для літаків. Цього ж року чоловік на ім’я Рей Ґрін завершив роботу над створенням першого композитного човна, повністю виготовленого зі скловолокна зі смоляним просоченням.

У 1953 році з’явився перший у світі автомобіль із кузовом зі склопластику — Chevrolet Corvette Roadster, представлений на виставці Motorama в Нью-Йорку. А в 1964 році було створено перший повністю склопластиковий планер. Завдяки легкості склокомпозиту, з якого він був виготовлений, планер міг довгий час залишатися в повітрі без будь-якої розгінної сили. Згодом зі склопластику почали виробляти басейни, електроізолятори, стінові панелі, сантехнічні труби, меблі та різні ємності.

У другій половині XX століття завдяки розвитку композитних технологій на зміну склопластикам прийшли вуглепластики — ще міцніші й легші матеріали, які складаються з вуглецевих волокон і полімерної смоли. Але й на цьому дослідження не закінчились.

Були розроблені композитні матеріали на основі арамідних волокон (таких як кевлар або тварон), які широко використовуються у виробництві бронежилетів і касок, автомобільних деталей, спортивного екіпірування для екстремальних видів спорту, а також спецодягу та обмундирування. Наприкінці XX століття почалися дослідження та розробки нанокомпозитів — матеріалів, у яких для посилення армувальних волокон використовуються наночастинки. Завдяки своїм унікальним механічним, тепловим та електричним властивостям нанокомпозити широко застосовуються у стоматології, літакобудуванні, електронному обладнанні та системах безпеки.

Значення композитних матеріалів у світі складно переоцінити. І якщо називати історичні епохи за матеріалами, які переважали в діяльності людини (за аналогією із залізним чи бронзовим віком), то сьогодення можна упевнено назвати композитним віком.

Копіювальний апарат Джеймса Ватта

Перший копіювальний апарат на основі електрографії (ксерографії)

Від копіювального паперу до електронних копіювальних апаратів

Навіть у стародавніх цивілізаціях існувала необхідність у веденні записів, складанні документів для обліку майна та ресурсів. З цієї причини вже в Стародавньому Єгипті й Месопотамії з’явилися перші секретарі й канцеляристи — прообрази сучасних офісних працівників.

У середньовічній Європі стали виникати центри адміністративного управління, такі як королівські палаци й церковні установи, де працювали писарі та діловоди, які забезпечували адміністративні функції. Виконуючи роботу, співробітникам таких установ часто доводилося складати копії документів, наприклад, щоб передавати їх декільком зацікавленим сторонам.

Вирішувалося таке завдання досить просто — писарі вручну створювали необхідну кількість копій. Однак із розвитком промисловості та торгівлі наприкінці XVIII століття, коли в західних країнах почали утворюватися великі компанії та фірми з великим документообігом, пов’язаним з бухгалтерією та різними юридичними аспектами, обсяг такої роботи значно збільшився, і виникла потреба у створенні технологій механічного копіювання документів.

Ще в 1780 році Джеймс Ватт, той самий, чиїм ім’ям у фізиці названа одиниця потужності, запатентував перший копіювальний апарат, який згодом широко застосовувався в офісах навіть у XX столітті. Суть роботи цього пристрою полягала в тому, що чорнило з лицьового боку оригіналу переносилося на зворотний бік іншого листа, змоченого розчинником і притиснутого до оригіналу. Недоліком такого методу було те, що копію треба було читати на просвіт — піднісши до світла, щоб бачити текст крізь тонкий папір.

У 1801 році італієць Пеллеґріно Туррі винайшов копіювальний папір — тонку підкладку з нанесеним на одну зі сторін шаром барвника. Поклавши копірку під аркуш паперу, можна було отримати копію тексту чи малюнка, зробленого олівцем або кульковою ручкою. Але повсюдно використовувати винахід Туррі для копіювання стали тільки після масового поширення друкарських машинок.

Слід зазначити, що копіювальний папір застосовувався в офісній діяльності до початку 1990-х років. А ще його любили діти, адже за допомогою цього паперу було дуже зручно копіювати картинки з журналів, обводячи зображення олівцем. Єдиним недоліком копіювального паперу, мабуть, було те, що при неправильному розташуванні (шаром барвника догори) зробити копію було неможливо, а на звороті оригіналу з’являлося дзеркальне відображення тексту або малюнка.

Справжній переворот у копіюванні документів зробив американець Честер Карлсон. Працюючи в патентному бюро Нью-Йорка, він часто стикався з необхідністю виготовлення великої кількості копій документів. Карлсон страждав від захворювання суглобів — артриту, тому процес копіювання був для нього болючим і виснажливим. З цієї причини винахідливий клерк почав експериментувати з фотокопіюванням, використовуючи як лабораторію власну кухню.

У результаті 1938 року Карлсон отримав патент на електрофотографію — процес сухого копіювання зображень. Першу фотокопію винахідник зробив за допомогою цинкової пластини, покритої сіркою: помістивши скло з написом на шар сірки та подавши яскраве світло, він зміг отримати дзеркальне відображення слів на пластині. Оскільки процес був недостатньо розвинений, продати свою розробку Карлсону не вдалося. Різні компанії вважали, що потреби в електронних копіювальних апаратах просто немає.

Лише 1944 року Меморіальний інститут Баттеля уклав із Карлсоном контракт щодо удосконалення його процесу. А 1947 року виробник фотопаперу — корпорація Haloid захотіла придбати ліцензію на розробку та продаж копіювального апарата, заснованого на електрофотографії.

Маркетологи з Haloid вважали, що електрофотографія — надто складне для запам’ятовування слово, тому змінили назву процесу на ксерографію — у перекладі грецької «сухе письмо». А згодом і цей термін скоротили до «ксерокс», зареєструвавши в 1948 відповідну торгову марку Xerox. До речі, саме ця назва у 1961 році змінила стару назву корпорації Haloid.

У 1949 році був представлений перший ксерографічний копіювальний апарат Model A. Успіх був настільки великим, що незабаром назва марки «Ксерокс» стала загальною для будь-якого процесу фотокопіювання.

На початку 1950-х років компанія Radio Corporation of America (RCA) представила власний варіант ксерокопіювання, при якому зображення формуються безпосередньо на папері зі спеціальним покриттям. Трохи згодом з’явилися повноколірні копіювальні апарати, здатні відтворювати кольорові копії. Однак у продажу подібні пристрої з’явилися лише 1968 року. При цьому кольорове фотокопіювання тривалий час викликало стурбованість урядів, оскільки вважалося, що воно полегшує підробку грошей та важливих документів.

У наступні десятиліття процес електронного копіювання безперервно вдосконалювався, проте до кінця 1970-х років для ксерокопій був потрібний спеціально підготовлений офісний папір.

Сучасні ксерокси використовують для роботи звичайний необроблений офісний папір і оснащені такими корисними функціями, як двосторонній друк, автоматичне сканування кількох сторінок, сортування та зшивання виведених копій. Цифрові технології, які замінили аналогові, дають змогу автоматично підвищувати якість зображення, а також надсилати відскановані документи електронною поштою або розміщувати на файлообмінних серверах.

Сьогодні без ксерокопіювальних апаратів неможливо уявити жоден сучасний офіс. Ксерокси широко застосовуються в освіті та наукових дослідженнях для створення копій навчальних матеріалів, статей і наукових публікацій. Ксерокопіювання відіграє важливу роль у дублюванні документів, таких як судові рішення, договори, заяви та інші юридично значущі матеріали. Це допомагає зберігати архіви й забезпечувати доступ до необхідних даних. У медичних закладах ксерокопіювання використовується для зняття копій із медичних карт, рецептів, результатів аналізів та інших медичних документів.

Таким чином, ксерокопіювання знаходить широке застосування в різних сферах діяльності та відіграє важливу роль в обміні інформацією, у документообігу та обробці даних у сучасному світі.

Перший комп’ютер Z1

Програмований комп'ютер для військових цілей

У всі часи люди намагалися придумати засоби, які б спростили та прискорили процес математичних обчислень. І що складнішими були ці обчислення, то різноманітнішими ставали обчислювальні пристрої: лічильні палички в доісторичні часи, перші рахівниці у Вавилоні, логарифмічна лінійка і калькулятор Паскаля в XVII столітті, механічний калькулятор Беббіджа на початку XIX століття.

На початку XX століття для задоволення потреб у наукових і практичних обчисленнях були потрібні вже повноцінні аналітичні пристрої, здатні обробляти великі обсяги даних і виконувати складні функції для вирішення тих чи інших завдань. З цією метою розроблялися дедалі досконаліші аналогові комп’ютери — складні обчислювальні машини, у яких основою для обчислень були різні фізичні явища (механічні, гідравлічні чи електричні величини). Однак такі комп’ютери не піддавалися програмуванню і, як правило, не мали такої універсальності й точності, як сучасні цифрові комп’ютери.

У 1930-ті роки розвиток електротехніки дав змогу вченим створювати перші прилади, здатні виконувати різні операції відповідно до заданих інструкцій. І хоча такі прилади були електромеханічними, тобто електричні компоненти поєднувалися в них із механічними вузлами, проте саме ці машини стали першими справжніми комп’ютерами — прабатьками сучасних цифрових комп’ютерних систем.

Перший електромеханічний комп’ютер був розроблений 1938 року ВМС США. Це був досить компактний пристрій, щоб його можна було застосувати на борту підводного човна. Цей комп’ютер використовував тригонометрію для вирішення завдання стрільби торпедою по рухомій цілі. Комп’ютер даних торпед (Torpedo Data Computer або скорочено TDC) не просто пропонував рішення для миттєвої стрільби, але й міг автоматично відслідковувати ціль, чим згодом встановив своєрідні стандарти управління торпедним вогнем підводних човнів під час Другої світової війни.

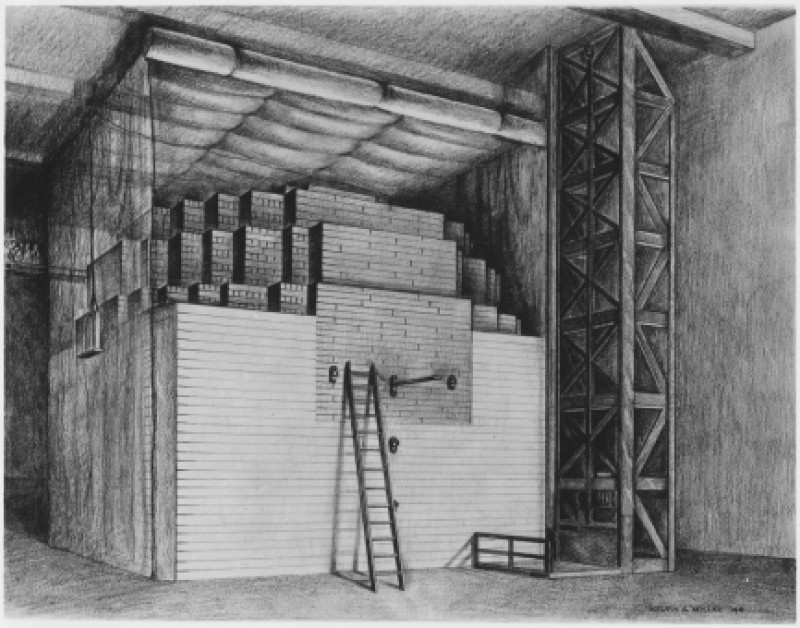

У тому ж 1938 році німецький інженер Конрад Цузе побудував перший у світі програмований комп’ютер Z1, який містив близько 30 тисяч металевих деталей. Ця машина мала використовуватися у сфері літакобудування для обчислення аеродинаміки та інших характеристик.

У 1939 році Цузе був призваний на військову службу, де йому надали ресурси для створення Z2. Машина, яка була удосконаленою версією Z1, була готова у вересні 1940 року і займала кілька кімнат у квартирі батьків винахідника.

1940 року уряд Німеччини почав фінансувати розробку обчислювальних машин S1 і S2, відмінною особливістю яких був вбудований аналогово-цифровий перетворювач під програмним управлінням, що робило їх першими комп’ютерами з управлінням процесом.

У 1941 році базова машина Z2 зазнала чергових удосконалень, і Цузе представив публіці модель Z3. Цей комп’ютер був 22-бітовим двійковим калькулятором із рухомою комою, що відрізнявся можливістю програмування за допомогою циклів, але без умовних переходів, з пам’яттю та обчислювальним пристроєм на основі телефонних реле.

Роботи над Z4 були перервані тим, що після бомбардування союзними військами у лютому 1945 року практично всі розробки Цузе були знищені. Талановитий учений зміг продовжити свої дослідження лише після війни.

Слід зазначити, що Друга світова війна дала потужний поштовх появі та розвитку перших комп’ютерів. Крім гострої потреби у вирішенні складних військових завдань, таких як балістичні обчислення, шифрування повідомлень, управління артилерією, існувала потреба у захисті військової інформації. А розшифрування кодів супротивника та розробка власних безпечних кодів потребували значних обчислювальних потужностей.

Так, наприклад, помітний внесок у поразку нацистської Німеччини зробило розшифрування повідомлень, закодованих за допомогою німецької шифрувальної машини «Еніґма». Створений для цієї мети англійцем Аланом Тюрінґом комп’ютер Bombe після війни масово випускався вже для цивільних потреб: було зроблено понад 200 екземплярів.

Американський інженер-електрик Джон Атанасов також зробив свій внесок у появу комп’ютерної техніки завдяки створенню у 1942 році електромеханічного обчислювального пристрою, який використовувався для арифметичних операцій та вирішення лінійних рівнянь. 1973 року судова влада США навіть визнала саме машину Атанасова «першим комп’ютером», хоча таке рішення і було не зовсім справедливим.

Історія появи комп’ютера буде неповною без згадки ще однієї американської обчислювальної машини, побудованої 1946 року Джоном Моклі. Пристрій, що отримав назву ЕНІАК (ENIAC, скорочення від Electronic Numerical Integrator and Computer — електронний числовий інтегратор і обчислювач) можна з упевненістю назвати першим повністю електронним комп’ютером, оскільки, на відміну від машин Цузе, у яких використовувалися механічні реле, в ЕНІАКу застосовувалися електронні лампи. Потужний на той час комп’ютер використовувався для розрахунку балістичних таблиць.

Перші комп’ютери продемонстрували можливість автоматизації та прискорення широкого діапазону завдань, зокрема математичних обчислень, наукових та інженерних розрахунків, обробки даних та управління процесами. Ці пристрої лягли в основу подальшого розвитку комп’ютерної техніки й відіграли ключову роль у формуванні сучасного інформаційного суспільства. Саме перші комп’ютери сприяли розвитку програмування як науки та мистецтва. Програмування стало необхідною навичкою для роботи з комп’ютерами, і в процесі його розвитку було сформульовано чимало принципів і методів, які продовжують застосовуватися досі.

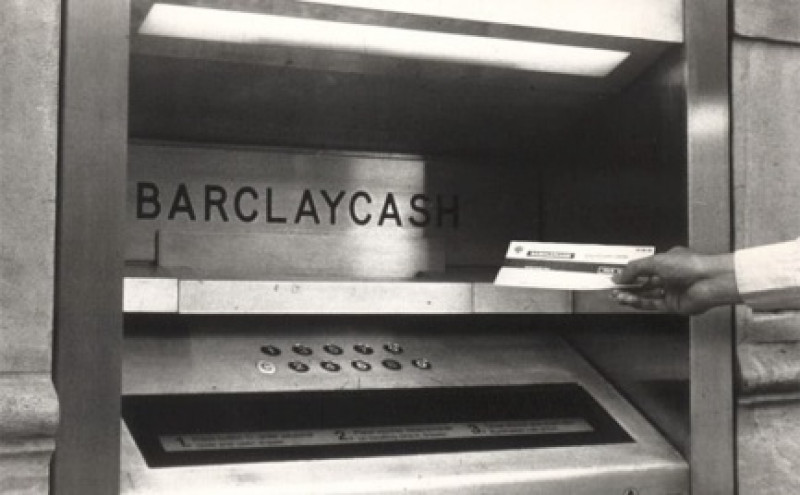

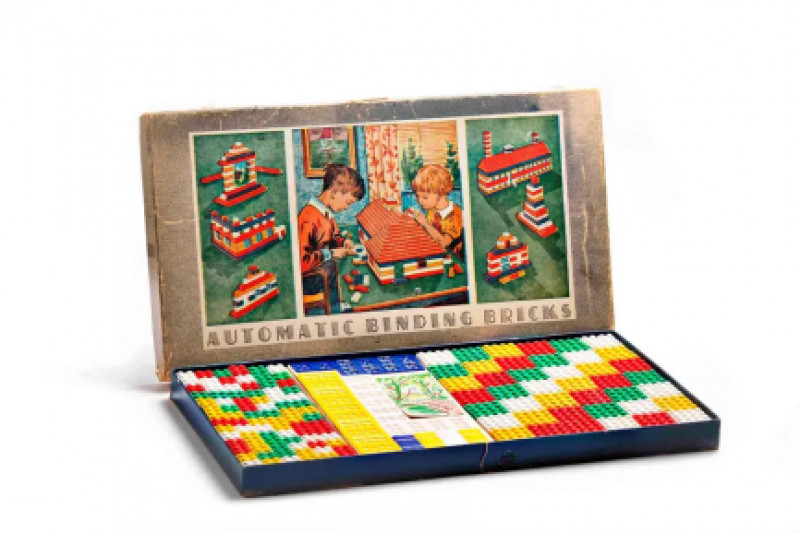

33 роки банки відмовлялися встановлювати банкомати!

Американський винахідник вірменського походження Лютер Джордж Сімджян має понад 200 патентів, серед яких камера з автофокусуванням, телесуфлер та кольоровий рентген. Але його найвідоміший винахід, без якого сьогодні неможливо уявити собі сучасність, у буквальному розумінні значно випередив свій час.

У 1939 році Сімджян створив банкомат — пристрій, який видавав готівку клієнтам банку в неробочий час. Єдиним, що відрізняло прототип Сімджяна від сучасних апаратів, було те, що банкомат видавав готівку, але не списував її з рахунку, оскільки не був пов’язаний із банком. Випробувавши свій винахід, Джордж Сімджян запропонував його банку City Bank of New York, який через пів року повернув йому машину, так і не оцінивши прогресивність пристрою. Після цього про банкомат забули майже на 30 років — «друге народження» банківського автомата відбулося лише наприкінці 1960-х.

Примітно, що друга спроба автоматизувати банківські операції була зроблена Сімджяном в 1960 році, коли він створив автоматичний депозитний автомат, що цілодобово приймав монети, готівку й чеки. Машину, яка отримала назву «банкограф», було встановлено в Нью-Йорку 1961 року. Але вже за пів року її демонтували, оскільки великим попитом серед клієнтів вона не користувалася.

Більш вдалим досвід застосування банкомата був у шотландця Джона Шеппарда-Баррона. У 1967 році цей винахідник, надихнувшись принципом роботи автомата з продажу шоколаду, створив пристрій, який видавав готівку в обмін на чек, попередньо отриманий у банку. Банкомат Шеппарда-Баррона було встановлено на півночі Лондона у відділенні британського банку Barclays. Першим гроші за допомогою цього банкомата отримав актор-комік Реґ Варні, якого спеціально запросили з рекламною метою. Недоліком цього банкомата була відсутність можливості перевірити наявність грошей на рахунку клієнта, тому сума видачі готівки була обмежена 10 фунтами.

Значним нововведенням, реалізованим у банкоматі Шеппарда-Баррона, був чотиризначний захисний PIN-код (PIN — абревіатура від Personal Identification Number, або особистий ідентифікаційний номер). Патент на PIN-код на рік раніше отримав шотландський інженер Джеймс Ґудфеллоу. Згідно з легендою, спочатку винахідник планував зробити цей код 6-значним, але пізніше скоротив його до чотирьох символів, оскільки саме стільки цифр могла запам’ятати його дружина.

Англійський банкомат усього на дев’ять днів випередив розробку шведських банків під назвою Metior, і на місяць — пристрій з видачі готівки британського Вестмінстерського банку Chubb MD2.

Незабаром банкомати з’явилися в багатьох країнах світу. Уже 1971 року їх перші типи використовували приблизно 35 американських банків. А першим банком, який 1972 року почав установлювати банкомати повсюдно, став американський Citibank. Того ж року з’явилися перші онлайн-банкомати під назвою Cash-Point, розроблені компанією IBM. У них замість ваучера для видачі готівки використовувалися пластикові картки з магнітною смугою, що для клієнтів було набагато зручніше.

Подальший розвиток телекомунікацій дав змогу розбудовувати мережі банкоматів, які могли використовувати одразу кілька банків. До 1975 року кілька сотень пристроїв вісімнадцяти банків американського штату Вашингтон були об’єднані в мережу під назвою Exchange.

Наприкінці 1990-х набули поширення банкомати з функцією прийому готівки — cash-in. А в 2000-х виробники банкоматів почали впроваджувати технологію Cash Recycling, яка дозволила видавати на руки клієнтам готівку, до цього внесену в банкомат іншим клієнтом.

Великий вплив на індустрію банкоматів здійснив розвиток Інтернету та мобільних технологій. У 2010-х роках з’явилися безготівкові банкомати, які замість грошей видають клієнту рахунок, який той може пред’явити касиру магазину для оплати придбаного товару. Крім того, з’явилися технології, які дають змогу ідентифікувати клієнтів не за банківською карткою та паролем, а за введеною датою народження та прикладеною до сенсорного пристрою долонею.

Наразі банкомати виконують функції платіжних терміналів, валютообмінників та роздрібних кас самообслуговування. Вони розміщуються всередині приміщень або поза ними у банках, торгових центрах, аеропортах, продуктових магазинах, ресторанах, на залізничних вокзалах, станціях метро, заправних станціях. Банкомати є на круїзних лайнерах і навіть на деяких військових кораблях ВМС США, де моряки можуть отримати свою зарплату. Примітно, що один із банкоматів розташований на перевалі Хунджераб у Пакистані (висота 4693 метри), і він може працювати при температурі до –40 °С.

З розвитком технологій банкомати еволюціонуватимуть, стаючи розумнішими, зручнішими та безпечнішими інструментами для фінансових операцій. Ці пристрої продовжують відігравати ключову роль у забезпеченні доступу до фінансових послуг та мають перспективи розвитку в напрямку покращення сервісу, інновацій у технологіях і розширення доступу до послуг у різних регіонах.

Перша у світі балістична ракета

Що вигадали «Придурки з Тегеля»

Роботи зі створення балістичних і крилатих ракет розпочалися ще в кайзерівській Німеччині наприкінці Першої світової війни. Інженер Герман Оберт створив тоді проєкт великої ракети на рідкому паливі, оснащеної бойовим зарядом. Розрахункова дальність її польоту становила кілька сотень кілометрів.

Підписаний у Версалі мирний договір обмежував Німеччину в можливості нарощувати свій військовий потенціал з різних видів озброєнь, але це не стосувалося ракетної техніки. Роботу в цьому напрямку розпочала група інженерів із Берліна, яка називала себе «Придурки з Тегеля»: Рудольф Небель, Рольф Енґель, Курт Гайніш і Клаус Рідель. «Одного чудового дня, — стверджував Небель, — ракети витіснять артилерію і навіть бомбардувальники на звалище історії».